阅读时间大约10分钟以上(4095字)

阅读时间大约10分钟以上(4095字)

2025-05-13 Open X-Embodiment:全球最大开源机器人数据集,到底啥来头?

作者:陈康成 来源:机器觉醒时代

通常,从自然语言处理(NLP)到计算机视觉(CV)领域,基于在大规模、多样化数据集上训练的大参数规模通用模型,其性能往往优于在规模较小但更具任务针对性的数据集上训练的模型。

这种趋势推动了预训练模型的整合——以通用预训练主干模型为起点,逐步适应不同任务场景。也就是说,对于处理特定垂直领域的任务,基本上都可以通过微调通用基础模型来实现。

那么,在机器人领域,这一路线是否有效呢?

自然语言处理(NLP)和计算机视觉(CV)这两个领域都可以从网络上获取到大规模数据集,但在机器人领域却很难获得类似的大型、广泛数据集。当前,虽然也存在一些机器人数据集,但过于狭窄 —— 要么只关注单一环境、单一物体集,要么只关注狭窄的任务范围。因此,很难训练出一个大规模通用机器人模型。

如何才能克服机器人领域中的这些挑战?人们开始探索是否能够训练出一种“通用”的跨机器人(X-robot)策略,这种策略能够高效地适应新的机器人、任务和环境。

在论文《Open X-Embodiment: Robotic Learning Datasets and RT-X Models》中,研究者们通过提供标准化数据格式的数据集与模型,探索这一路径在机器人操作领域的可行性,并给出实验证据证明跨机器人策略(X-robot policies)的有效性。

本文主要围绕两方面内容进行展开:

Open X-Embodiment 数据集基础内容介绍

Open X-Embodiment 数据集测试验证解读

一、Open X-Embodiment 基础内容介绍

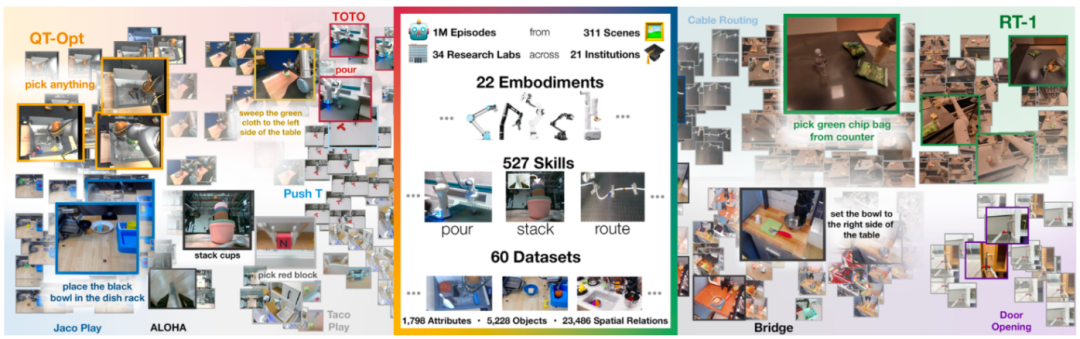

Open X-Embodiment 发布时间:2023年10月

发布者:谷歌DeepMind联合斯坦福大学、上海交通大学、英伟达、纽约大学、哥伦比亚大学、东京大学、日本理化研究所、卡内基梅隆大学、苏黎世联邦理工学院、伦敦帝国理工学院等21个机构(34个实验室)。

开源目的:为机器人学习领域提供一个大规模、多样化的数据资源,以推动机器人策略的泛化和跨平台学习能力。

机器人类型:涵盖单臂机器人、双臂机器人和四足机器人等22种不同类型的机器。

数据集规模:整合了60个已有数据集,涵盖311个场景、 100 多万条真实机器人轨迹,包括527种技能、160266项任务。

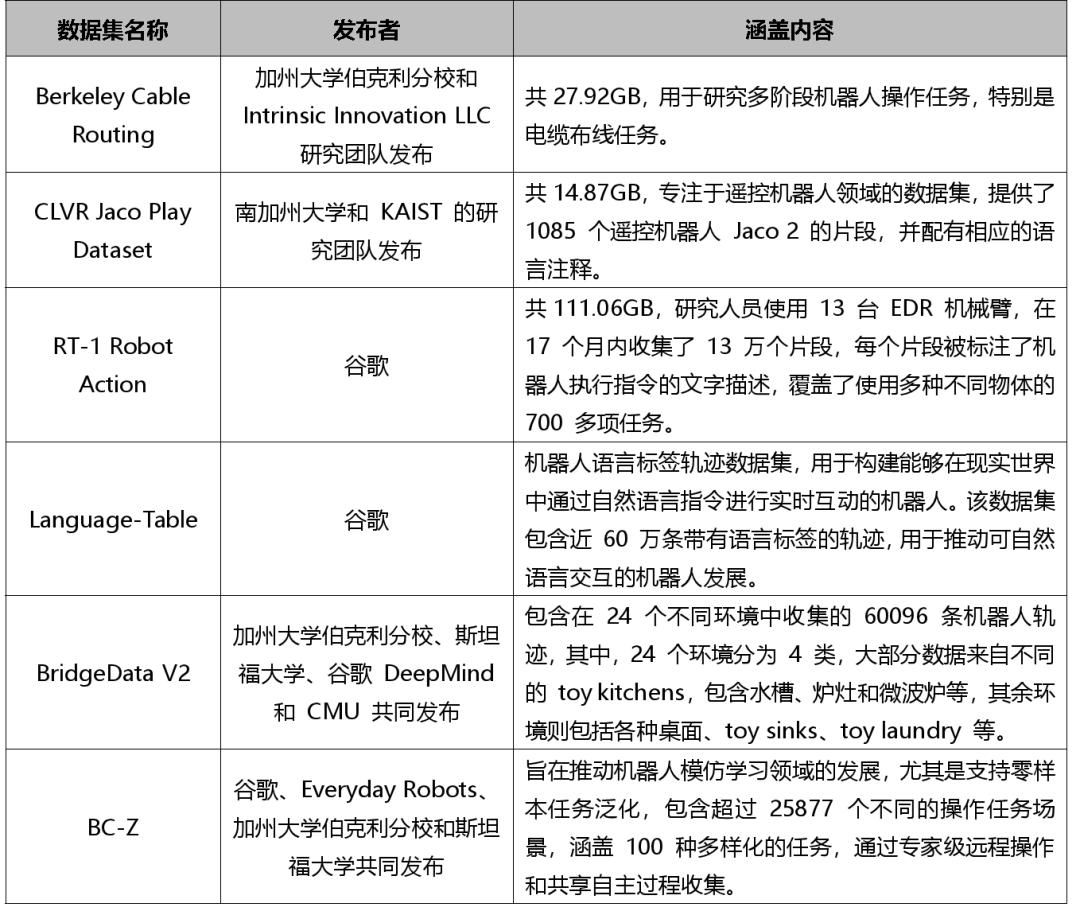

这60个数据集包括:Berkeley Cable Routing 数据集、CLVR Jaco Play Dataset、RT-1 Robot Action 数据集、Language-Table 数据集、BridgeData V2 数据集、BC-Z 数据集等。

数据集格式:所有源数据集统一转化为RLDS格式,便于下载和使用。

—— 该格式能够适应不同机器人设置的各种动作空间和输入模态,比如不同数量的 RGB 相机、深度相机(RGB-D相机)和点云数据。

—— 支持在所有主流深度学习框架中进行高效的并行数据加载。

不同数据源数据处理:包括多视角处理、图像尺寸调整和动作转换等。

1)多视角处理

不同数据集的视角信息差异极大。数据采集所使用的相机类型多样,包括RGB 相机与 RGBD 相机;从相机位置来看,有周视相机、腕部相机,部分数据集中所使用的相机数量甚至多达 4 部以上。

对于存在多视角的数据集,只会挑选其中一个被定义为“canonical” 的视角图像。这个图像通常是最接近自上而下第一人称视角的,或是与本体感知相关的,亦或是清晰度较高的那一个。

2)图像尺寸调整

将图像resize到320×256(width×height)。(据相关人士透露,实际上各个团队提交的数据规格并没有完全和Google保持一致。)

3)动作转换

将原有的动作(如关节位置)转换为末端执行器的动作,动作量可能为相对值或绝对值。在模型输出动作标记(action tokens)后,根据不同的机器人做不同的逆归一化(de-normalization)后再下达具体的控制指令。

数据集构成

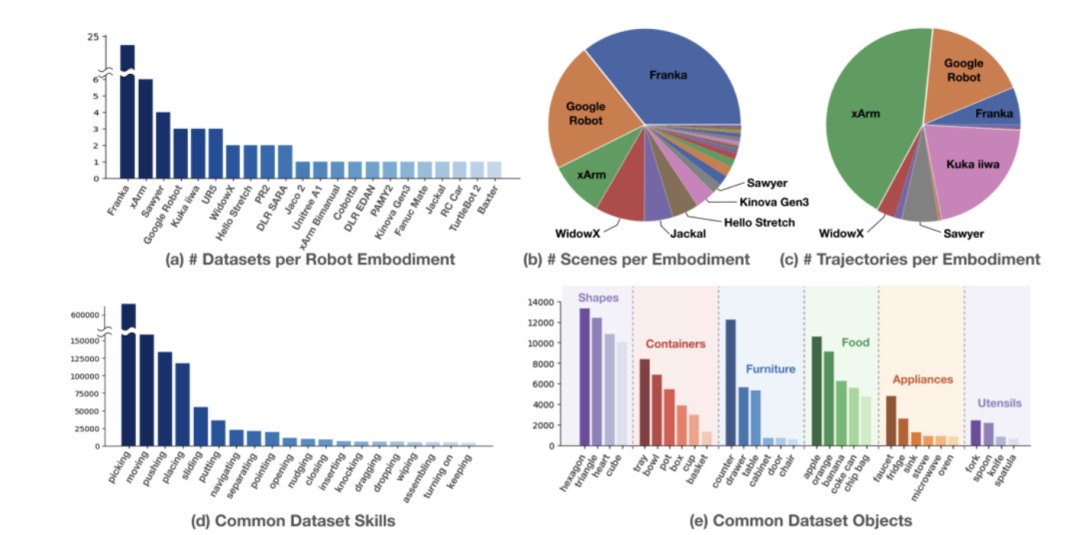

1)在使用机器人类型上,数据集中涉及的机器人包括单臂、双臂和四足机器人,图 (a) 展示了 22 种类型机器人数据集的分布情况,其中Franka、xArm、Sawyer机器人占多数。

2)在场景分布上,图 (b) 展示了机器人在不同场景的分布情况,Franka机器人占据主导地位,其次是Google Robot和xArm。

3)在轨迹分布上,图 (c) 则展示了每个形态机器人的轨迹分布情况,xArm贡献了最多的轨迹数量,其次是Google Robot、Franka、 Kuka iiwa 、Sawyer和WidowX。

4)在数据集中常见的技能上,由图(d)可以看出,技能上主要集中在Picking(抓)、Moving(移动)、Pushing(推)、Placing(放),整体呈现长尾分布,尾部有许多如Wiping、Assembling、Turning on等难度更高的技能。

5)在数据集常见的物品上,图 (e) 展示了机器人所用的物品,物品有家用电器、食品和餐具等,种类繁多。

二、Open X-Embodiment 数据集实验验证过程解读

1. 模型选择:RT1和 RT2

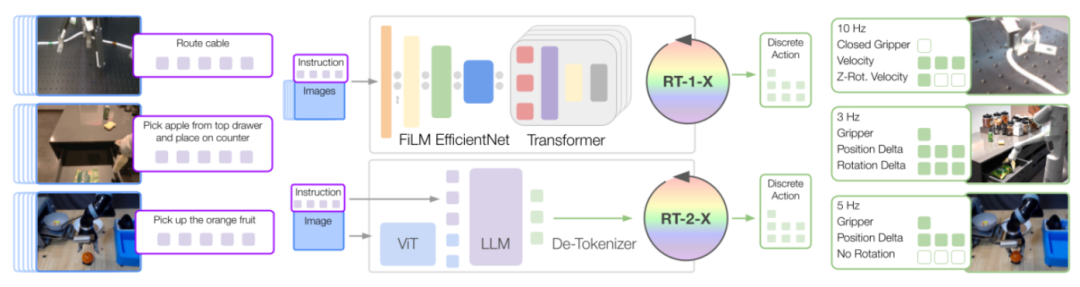

1)RT-1 :是一个基于 Transformer 架构的 3500 万参数网络,专为机器人控制设计。其输入包含 15 帧历史图像 和 自然语言指令。

每帧图像通过 ImageNet 预训练的 EfficientNet提取视觉特征,自然语言指令则通过 Universal Sentence Encoder (USE)转换为嵌入向量。

视觉与语言表征通过 FiLM 层(Feature-wise Linear Modulation)融合,生成 81 个视觉-语言联合表征令牌(vision-language tokens)。这些令牌随后输入到仅含解码器的 Transformer 架构 中,最终输出离散化的动作令牌(tokenized actions)。

2)RT-2 :是一个基于大规模互联网视觉-语言数据和机器人控制数据训练的视觉-语言-动作模型(Vision-Language-Action Models, VLAs)。

RT-2 将离散化的动作编码为文本形式的符号(token),例如,一个动作可能表示为“1 128 91 241 5 101 127”。通过这种方式,任何预训练的视觉语言模型(Vision-Language Models, VLM )均可通过微调适配机器人控制任务,从而继承其主干网络的表征能力,并迁移其部分泛化特性。

在论文中,重点研究 RT-2-PaLI-X 变体,其主干网络由视觉模型 ViT(Vision Transformer)和语言模型 UL2构成,并基于 WebLI数据集(覆盖互联网多模态数据)进行了大规模预训练。

2. 训练数据使用

所使用数据集:在实验中使用的机器人数据混合集包括9种机械臂,12个子数据集的数据。

12个数据集包括:RT-1、QT-Opt、Bridge、Task Agnostic Robot Play、Jaco Play、Cable Routing、RoboTurk、NYU VINN、Austin VIOLA、Berkeley Autolab UR5、TOTO和Language Table。

备注:在训练RT-1-X 和 RT-2-X 时,并未使用 Open X-Embodiment 的全部数据。数据仅涵盖了 22 个机械臂中的 9 个,以及 60 组子数据集中的 12 组,总计 1,131,788 条数据。作者在论文中解释,这是因为数据集处于持续增长状态,在开展 RT-X 相关实验时,这 12 组数据即为当时数据集的全部内容。

其中,RT-1-X:仅使用上述机器人数据混合集进行训练;RT-2-X:采用与原 RT-2类似的联合微调(co-fine-tuning)策略,以约 1:1 的比例混合原始视觉语言模型(VLM)数据与机器人数据。

在推理阶段,每个模型均以机器人所需的运行速率(3-10赫兹)执行:RT-1在本地运行,而RT-2托管于云服务并通过网络请求调用。这种部署方式确保了不同架构模型的运行效率需求都能得到满足。

数据格式统一:由于不同机器人的观测空间和动作空间差异显著。因此,在使用时,将其粗略对齐:

输入:一段窗口历史图像(统一分辨率)和自然语言指令(language embedding with USE);

输出:7维末端执行器动作离散量(6D for EE: x, y, z, roll, pitch, yaw and 1D for gripper)外加对轨迹状态的说明(terminate_episode)。

3. 实验验证过程

实验旨在探究X-具身训练(X-embodiment training) 效果的三个核心问题:

正向迁移能力验证:基于X-具身数据集训练的策略能否有效实现正向迁移?即通过多机器人数据联合训练(co-training) 是否可以实现正向迁移,从而提升目标任务性能?

泛化能力验证:在多平台、多任务数据上的联合训练是否能提升模型对未见任务(unseen tasks) 的泛化能力?

不同设计维度影响分析:模型规模、架构或数据构成等设计维度(design dimensions) 对策略性能及泛化能力有何影响?

1)跨具身的分布内性能评估

“分布内性能”指模型在训练数据分布范围内(即已见过的任务或场景)的表现。目的在于通过测试模型在分布内任务上的表现,可判断模型是否成功整合了多源异构数据的能力。

a. 实验设计

通过对比小规模数据集领域与大规模数据集领域,期望能够验证两个假设:

小规模数据领域,跨数据集迁移学习(如利用其他机器人的大规模数据)可以显著提升模型性能;

大规模数据的领域,模型性能可能接近瓶颈,改进空间有限。

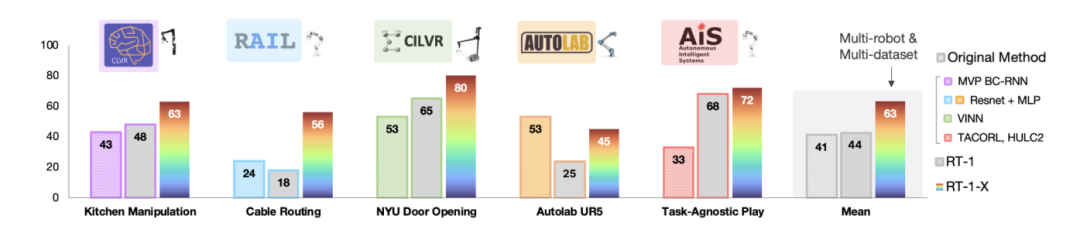

其中,小规模数据集评估选用:Kitchen Manipulation、Cable Routing、NYU Door Opening、AUTOLab UR5和Robot Play 共5个数据集。并且,在评估测试时,仅对比RT-1-X模型性能;

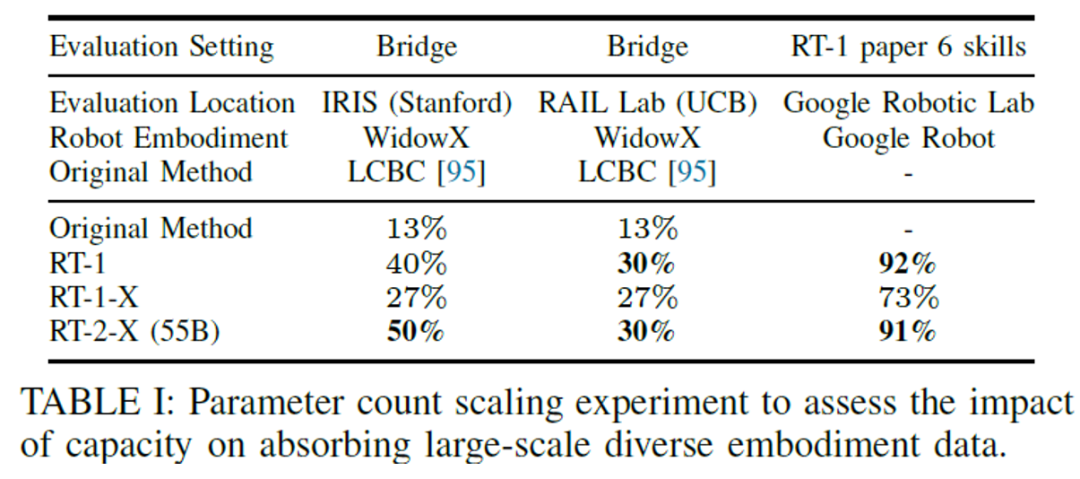

大规模数据集评估选用:Bridge数据集(对应WidowX机器人)和RT-1数据集(对应Google Robot)。并且,在评估测试时,同时评估RT-1-X与RT-2-X模型。备注:所有模型均通过全量X-具身数据集进行协同训练。

另外,实验中设置双重基线(基准)对比:

原生方法模型:由数据集创建者开发的专用模型,仅使用对应数据集训练。

独立训练RT-1:仅使用目标数据集单独训练的RT-1模型。

b. 实验结果显示

小规模数据集:如下图所示,RT-1-X模型在5个数据集中的4个上表现优于仅使用单一数据集训练的基准模型。RT-1-X的平均成功率比原始方法或RT-1高出50%。

由于RT-1与RT-1-X具有相同的网络架构,这表明RT-1-X性能的提升可归因于对机器人数据混合集的联合训练。

大规模数据集:如下表所示,在大规模数据场景,RT-1-X未能超越仅使用特定具身数据集训练的RT-1基线,表明该模型类别存在欠拟合问题。

然而,在Bridge数据集,斯坦福的IRIS评估中,RT-2-X(55B)模型同时超越了原生方法模型和RT-1,

这在一定程度上说明,对于具有足够参数规模的模型来讲,通过混合数据的训练,虽然改进空间有限,但仍然在能够提升模型性能。

2)分布外场景泛化能力的提升

a. 实验目的:为了探究跨具身训练(融合多机器人数据)如何增强模型在分布外场景及复杂新指令下的泛化性能。

b. 实验设计:本组实验聚焦大规模数据集领域,采用RT-2-X模型。主要测试内容包括:未见物体/背景/环境下的泛化测试、跨平台技能涌现评估和Bridge数据集消融实验。

c. 实验结果:

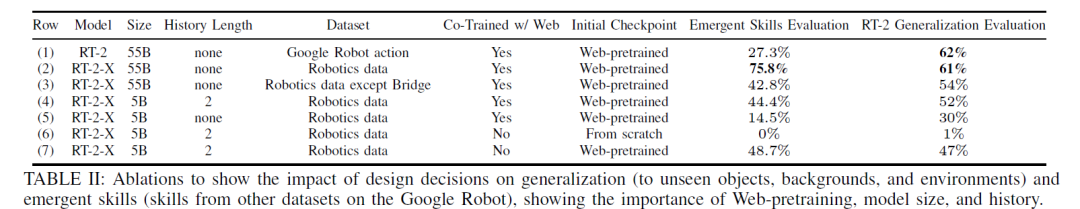

备注:消融实验揭示设计决策对泛化能力(未见物体/背景/环境)与跨数据集技能涌现(Google Robot平台)的影响,验证网络预训练、模型参数规模及历史观测的关键作用。

备注:消融实验揭示设计决策对泛化能力(未见物体/背景/环境)与跨数据集技能涌现(Google Robot平台)的影响,验证网络预训练、模型参数规模及历史观测的关键作用。

—— 未见物体/背景/环境泛化测试

测试模型在全新环境、背景中操作未见物体的泛化能力。实验结果显示,RT-2与RT-2-X表现基本持平(表II第1-2行末列),该结果符合预期,因RT-2凭借视觉语言模型(VLM)主干网络已在此类维度展现优异泛化性。

—— 跨平台技能涌现评估

为验证跨机器人知识迁移,我们在Google Robot平台执行如下图所示任务。这些任务涉及RT-2数据集中未包含、但存在于WidowX机器人Bridge数据集中的物体与技能。表II"技能涌现评估"列显示:对比第1-2行,RT-2-X较RT-2性能提升约3倍,表明即使对于已有海量数据的机器人,整合其他平台训练数据仍可拓展其任务执行范围。实验结果证实,跨平台协同训练使RT-2-X控制器获得该平台原始数据集之外的附加技能。

备注:该图为评估跨具身迁移能力,研究者在Google Robot平台测试RT-2-X对Bridge数据集独有技能(非Google Robot原生数据集内容)的掌握情况。

—— Bridge数据集消融实验

从RT-2-X训练集中移除Bridge数据(第3行),结果显示保留任务性能显著下降,证实WidowX数据迁移是RT-2-X在Google Robot上获得新技能的关键因素。

3)架构设计影响分析

通过消融实验量化不同设计决策对RT-2-X(当前最优模型)泛化能力的影响(表II)。关键发现包括:

历史观测信息:引入短期图像历史可显著提升泛化性能(第4 vs 5行);

网络预训练:基于网络数据的预训练对大型模型性能至关重要(第4 vs 6行);

模型参数规模:55B模型较5B模型在技能涌现评估中成功率显著更高(第2 vs 4行);证明更大参数规模的模型能够促进跨机器人数据迁移;

微调策略:协同微调与独立微调在泛化与技能涌现评估中表现相当(第4 vs 7行),归因于RT-2-X使用的机器人数据多样性远超以往历史数据集。

4)实验结论

实验证明基于Transformer的策略模型在该数据集上可实现显著的跨机器人正向迁移:

RT-1-X的平均成功率比原始方法或RT-1高出50%。

RT-2-X(视觉语言模型增强版)在评估平台数据上的泛化性能提升约3倍。

同时,也为机器人领域提供了以下研究资源:标准化X-机器人数据集;数据使用示例代码;作为研究基线的RT-1-X模型;

但是,该研究也存在一定的局限:尽管RT-X标志着向具身通用体(X-embodied generalist)迈进了一步,但实现该愿景仍需诸多突破:

未涵盖感知与执行机构差异比较大的机器人平台;

尚未系统研究跨平台泛化的决策边界与触发条件;

尚未建立正向迁移发生的量化决策准则。