阅读时间大约7分钟(2444字)

阅读时间大约7分钟(2444字)

2025-11-19 PI正式发布π∗₀.₆模型!机器人冲煮咖啡、叠衣服、折箱子技能都进化成这样了?!

作者:李鑫 出品:具身智能大讲堂

当机器人已经学会折叠不同材质的衣物、组装简易纸箱,并且还能熟练操作专业咖啡机制作浓缩咖啡,甚至连续工作13小时无故障,你是否也会惊讶现在的机器人进化速度如此之快。

近日,Physical Intelligence团队提出的RECAP训练方法,让VLA模型通过“实战经验+人类纠错”实现自我提升,并且同步推出π∗₀.₆模型。

1►RECAP方法——让机器人“边做边学”

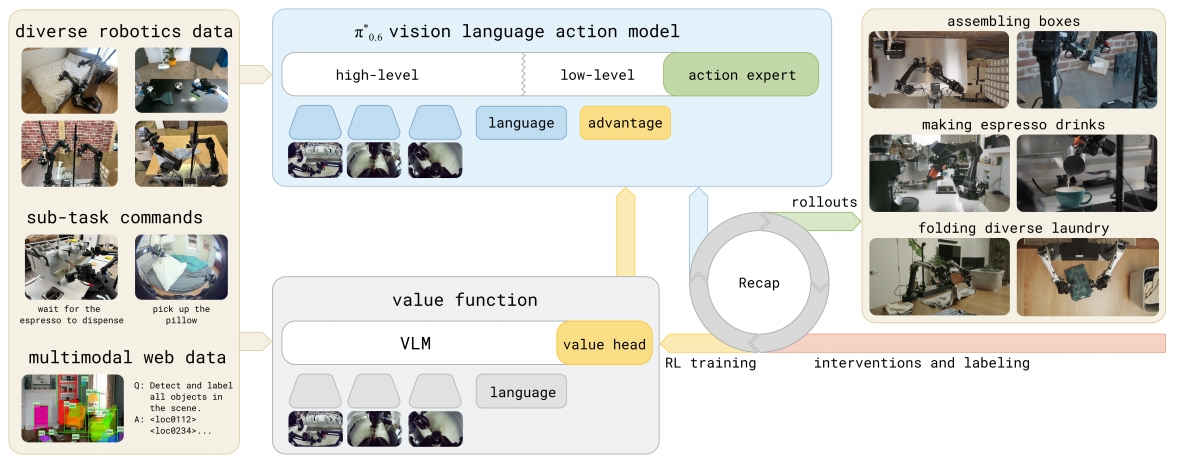

谷歌PI团队提出的RECAP(RL with Experience and Corrections via Advantage-conditioned Policies)方法,核心是给机器人构建了一套“实战学习闭环”,让模型能像人一样从实践中积累经验、修正错误。这套方法主要包含三个关键步骤:

1. 多源数据收集:实战+纠错双管齐下

模型部署到真实场景后,会自主执行任务并记录完整过程(即“自主轨迹”),同时人类专家会在旁监控。当机器人出现明显错误时,专家会远程干预纠正(即“人类纠错”),这些纠错数据会和自主轨迹一起存入训练库。

经验丰富的远程操作员接管控制权,对机器人的错误进行实时纠正。

这种数据组合兼顾了“量”和“质”:自主轨迹能提供大量真实场景的实战经验,暴露模型在不同情况下的问题;人类纠错则精准解决关键错误,避免模型在错误路径上越走越远。数据类型涵盖了演示数据、自主执行数据、专家干预数据等多种异质数据,为后续学习打下基础。

2. 价值函数训练:给机器人装“智能裁判”

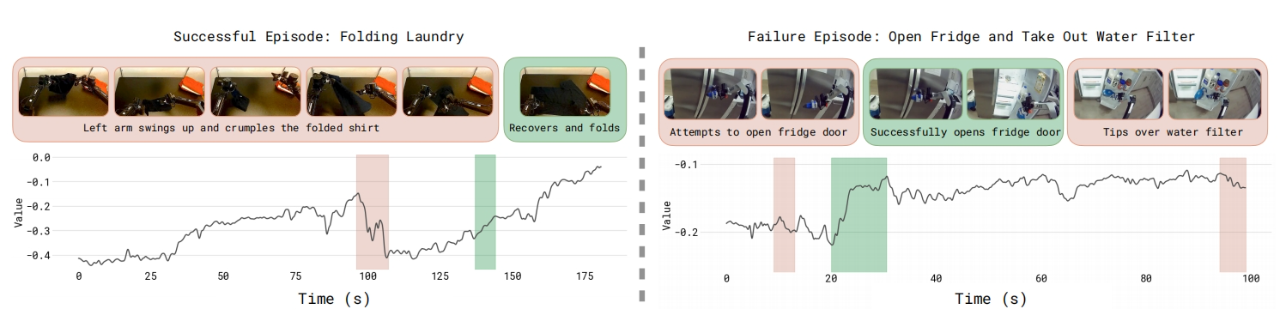

团队训练了一个多任务价值函数V^π_ref,相当于给机器人配了个能实时评估任务进展的“裁判”。这个价值函数会根据当前场景观察和任务指令,预测后续完成任务的概率和所需时间,还能识别失败征兆。

价值函数可视化解析。研究训练了一个多任务价值函数(VF),用于预测任务成功所需的剩余步数。

它的特别之处在于采用了分布式表示,能输出离散的价值区间分布,而非单一数值,这样能更精准地判断不同动作的优劣。比如在折叠衣物时,它能及时发现“衬衫边角未对齐”这种潜在错误,为后续动作优化提供依据。训练时,价值函数会根据任务结果(成功/失败)和完成时间进行优化,确保评估的准确性。

3. 优势条件训练:精准优化动作策略

这是RECAP的核心创新。模型会根据价值函数计算“优势值”——衡量当前动作比基准动作更优的程度,然后将这个优势值转化为二进制指标(“优势:正向”或“优势:负向”),作为额外输入融入VLA模型的训练。

通过模仿学习训练的基础模型,在执行意式咖啡机手柄插入任务时面临显著挑战。这类任务失败的核心原因往往源于早期动作偏差,即模型握住手柄的初始角度未满足设备安装的对准要求。

这种方式相当于让模型明确知道“哪些动作该坚持,哪些该改进”,能高效利用所有数据(包括成功案例和失败案例)进行政策优化。相比传统强化学习方法,它无需复杂的梯度调整,能直接适配大规模VLA模型,同时避免了数据浪费,让模型在有限数据下实现快速提升。

2►π∗₀.₆基于RECAP方法设计拥有两大核心优势:

π∗₀.₆是基于团队此前的π₀.₆模型优化而来,专为RECAP方法设计,主要升级点有两个:

一是加入了优势条件输入接口,能接收价值函数输出的二进制优势指标,让模型在生成动作时能参考“动作优劣”的判断;二是延续了π₀.₆的强大基础架构——采用Gemma 3 4B大模型作为VLM骨干网络,搭配860M参数的动作专家模块,通过流匹配(flow matching)生成连续动作,同时能输出子任务文本指令(如“拿起咖啡粉槽”),实现高层决策与底层动作的协同。

实验中所用任务的示意图。任务包括三种不同的衣物洗涤变体、组装箱子,以及用浓缩咖啡机制作咖啡饮品。

模型预训练阶段会吸收数万小时的多机器人、多任务数据,包括视觉-语言Web数据和机器人操作数据;之后针对具体任务(如折叠衣物、制作咖啡)进行微调,再通过RECAP的迭代训练不断优化,最终形成适配特定场景的专业模型。

3►真实场景下三大高难度任务,π∗₀.₆碾压传统强化学习

团队在三个高难度真实任务中对π∗₀.₆进行了测试,结果十分亮眼:

1. 任务覆盖:从家政到工业场景

•衣物折叠:能处理T恤、短裤、衬衫、牛仔裤等11种衣物,在陌生家庭环境中连续工作2小时无中断;

PI正式发布π∗₀.₆模型!机器人冲煮咖啡、叠衣服、折箱子技能都进化成这样了?!

观看更多转载,PI正式发布π∗₀.₆模型!机器人冲煮咖啡、叠衣服、折箱子技能都进化成这样了?!具身智能大讲堂已关注分享点赞在看已同步到看一看写下你的评论 视频详情

•浓缩咖啡制作:完成从磨豆、压粉、萃取到出杯的全流程,连续工作13小时稳定输出;

•纸箱组装:将扁平纸箱折叠成型、贴标签并堆叠,适配工厂真实包装场景,600秒内完成率超90%。

2. 关键指标:成功率与效率双提升

吞吐量:研究团队展示了衣物洗涤(简单款与多样款)、浓缩咖啡制作及箱子组装任务每小时的成功完成数量,误差线代表标准误。该指标同时衡量成功率与速度。在所有情况下,将 RECAP 应用于 π∗₀.₆(我们的方法)均显著提升了吞吐量。RECAP 对多样款衣物洗涤和浓缩咖啡制作任务的吞吐量影响最为显著,使每小时成功完成数量增加一倍以上。

•吞吐量翻倍:在最难的多样化衣物折叠和咖啡制作任务中,成功完成的任务数量 per 小时提升超过1倍;

•故障率减半:相比传统模型,π∗₀.₆的任务失败率降低约50%,其中纸箱组装的各子任务成功率均为最高;

•鲁棒性突出:能应对真实场景的 variability——如粘连的纸箱、易变形的衣物、液体倾倒时的晃动等,这些都是实验室数据难以模拟的情况。

3. 方法优势:碾压传统强化学习

对比AWR(优势加权回归)和PPO(近端策略优化)等传统方法,π∗₀.₆在吞吐量上表现出绝对优势。

不同策略提取方法的对比结果显示:与 AWR(优势加权回归)和 PPO(近端策略优化)相比,将 RECAP 方法应用于 π₀.₆* 模型后,其在衣物折叠任务中的吞吐量达到了目前最高水平。

其中PPO因需要严格的信任域约束,在离线数据场景下难以稳定训练;AWR虽能保证一定成功率,但动作速度慢,导致整体效率低下。而RECAP的优势条件训练既能保证稳定性,又能显著提升动作效率,充分验证了方法的优越性。

4►RECAP方法为通用机器人提供可复制方案

π∗₀.₆和RECAP方法的突破,不仅在于模型性能的提升,更在于为通用机器人的实用化提供了可复制的解决方案:

首先,它解决了传统机器人模型“怕陌生环境”的痛点,通过真实场景的自主学习和人类纠错,让模型能适应复杂多变的现实条件;其次,RECAP的迭代训练框架无需依赖大规模标注数据,降低了机器人适配新场景的成本;最后,模型在真实场景中的长时稳定运行能力,证明了VLA模型从实验室走向生活、工业场景的可行性。

未来,团队计划进一步优化三个方向:一是实现数据收集、标注、重置的全自动化,减少人类干预;二是提升模型的探索能力,让机器人能自主发现更优操作路径;三是构建全在线的RL训练循环,实现实时学习与优化。这些改进将推动通用机器人更快走进家庭、办公室和工厂,成为真正的“实用工具”而非“实验室展品”。

从π₀.₅到π∗₀.₆,谷歌PI团队用强化学习打通了“模型能力”与“真实场景”之间的鸿沟。当机器人能像人一样“从实践中学习”,通用机器人的时代,或许已不再遥远。

论文链接:https://www.physicalintelligence.company/download/pistar06.pdf

官方网站:https://www.physicalintelligence.company/blog/pistar