阅读时间大约5分钟(1861字)

阅读时间大约5分钟(1861字)

2025-12-02 重磅!武大提出RGMP框架!泛化成功率87%!数据效率提升5倍!

作者:李鑫 出品:机器人大讲堂

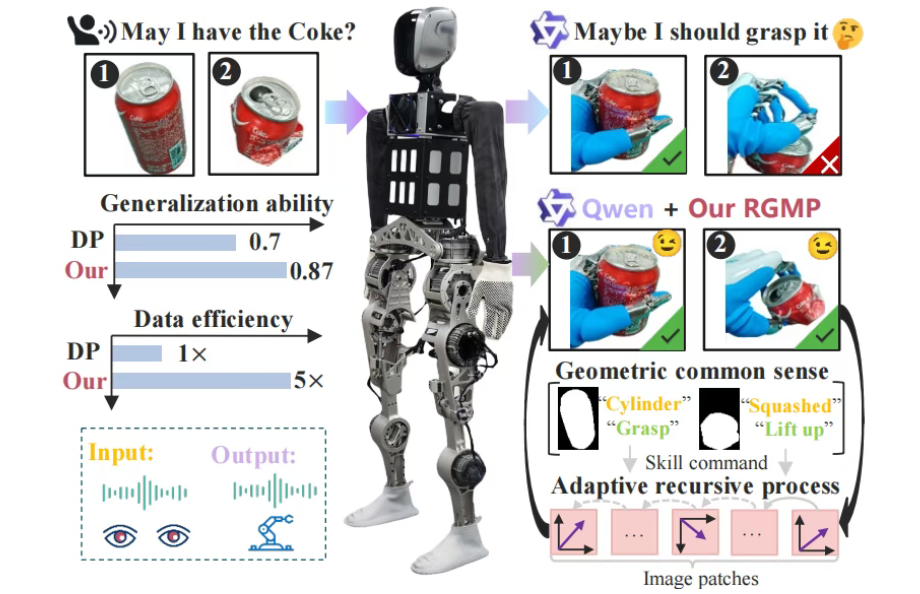

在人形机器人迈向实用化的道路上,数据依赖和环境适应能力一直是两大核心瓶颈。现有主流方案大多采用数据驱动模式,不仅需要海量训练样本支撑,还常常忽略几何推理能力,导致机器人在陌生场景中频繁“失灵”,大量训练资源也因此被浪费。

近日,武汉大学团队提出的递归几何先验多模态策略(RGMP)框架。该框架创新性地将几何语义技能推理与数据高效的视觉运动控制相融合,在人形机器人和桌面双臂机器人平台上,泛化测试任务成功率达到87%,数据效率更是较当前最先进模型提升5倍。

▍双模块协同:破解感知与运动的双重难题

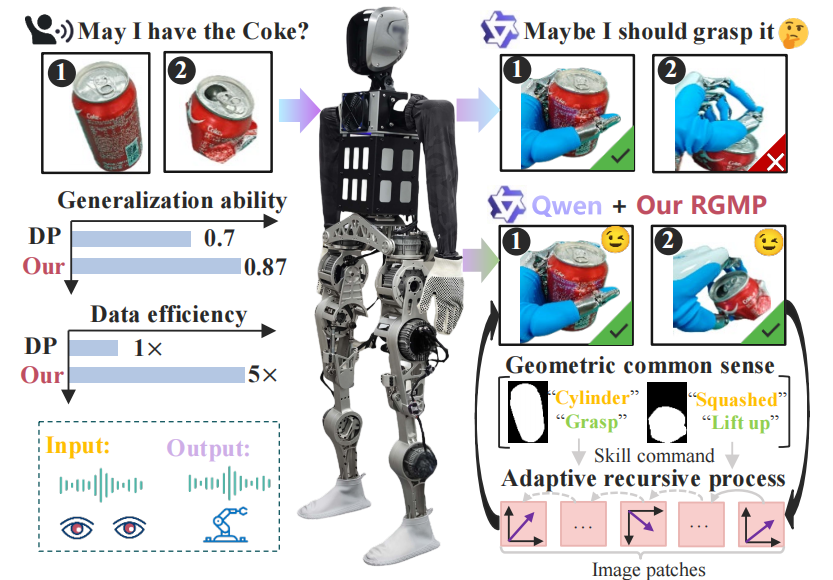

RGMP框架采用端到端设计,通过几何先验技能选择器(GSS) 和自适应递归高斯网络(ARGN) 的协同工作,解决了陌生场景下的技能选择难题同时,还实现了数据稀缺条件下的精准运动合成,整体架构简洁且高效。

▍几何先验技能选择器:给机器人装上“空间常识大脑”

GSS模块的核心创新在于将几何归纳偏置融入视觉语言模型,让机器人像人类一样结合视觉几何特征和任务语义选择合适技能。该模块采用模块化设计,具备即插即用特性,仅需20条基于规则的约束就能实现稳定性能,大幅降低了调优成本。

RGMP 的技术流程

主要工作流程分为两步:第一步通过视觉语言模型解析人类指令,在图像中识别目标物体并定位边界框;第二步结合目标物体的相对位置、形状等常识信息,从预训练技能库中匹配最优技能。例如,当接收到“我想要芬达”的指令时,系统会先通过Yolov8n - seg模型提取芬达罐的形状信息,识别出其“圆柱形”特征,再依据几何先验知识自动选择“侧面抓取”技能;而面对压扁的可乐罐时,则会适配“抬起”技能。

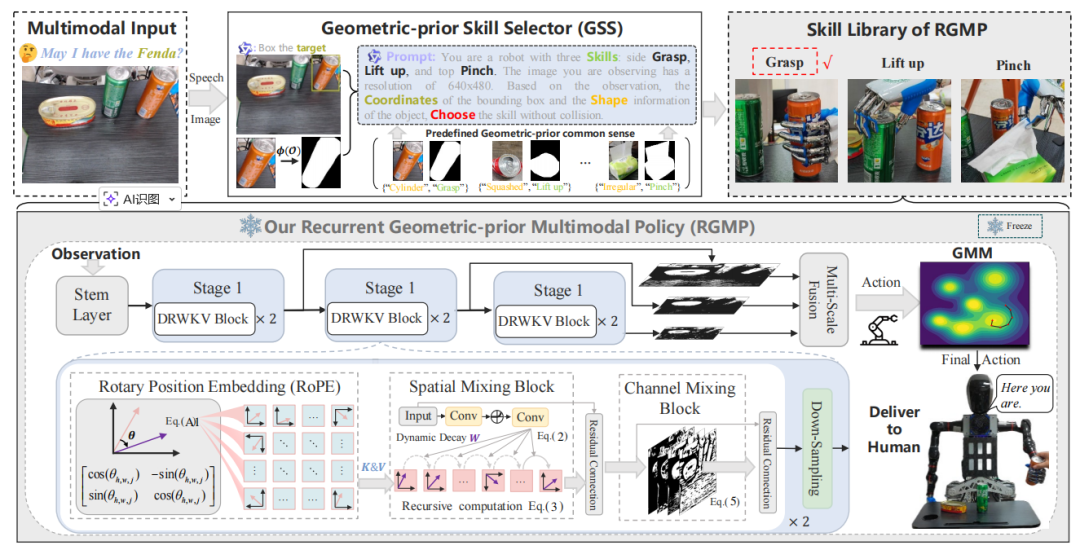

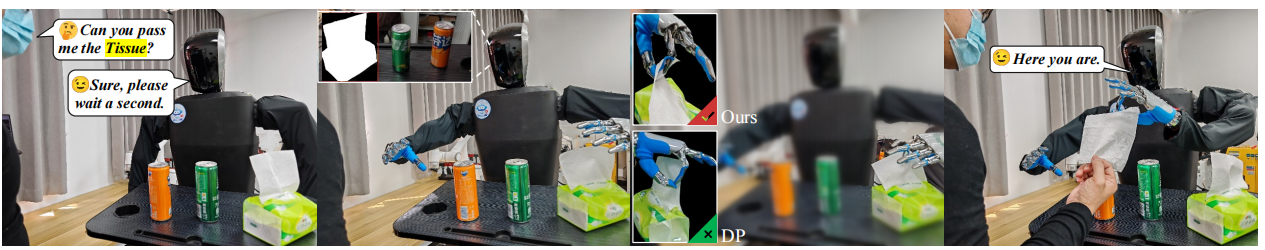

人机交互流程及模型验证

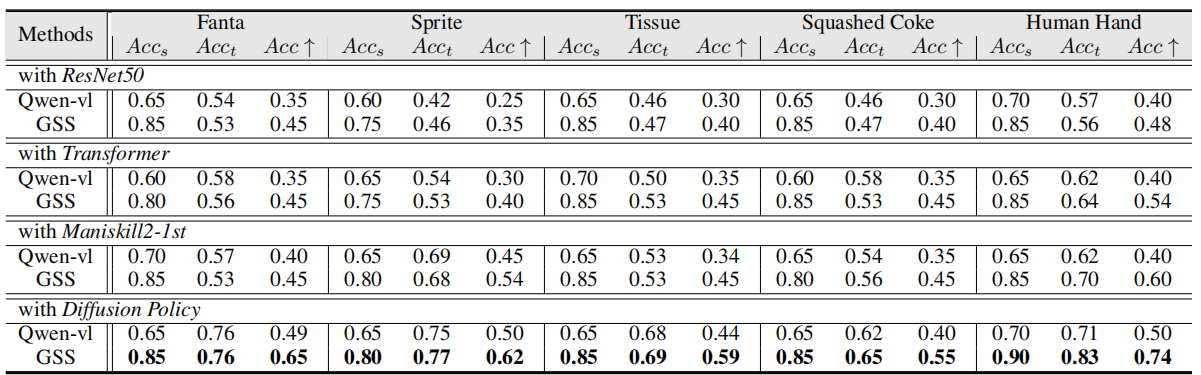

在对比实验中,无论是搭配ResNet50、Transformer还是Maniskill2 - 1st等不同骨干网络,GSS的技能选择准确率都比基础的Qwen - vl模型高出15%-25%。在人类手部、喷雾瓶等复杂目标的操控任务中,优势尤为明显,充分验证了其在处理不同形状物体时的鲁棒性。

▍自适应递归高斯网络:让机器人运动“精准又省数据”

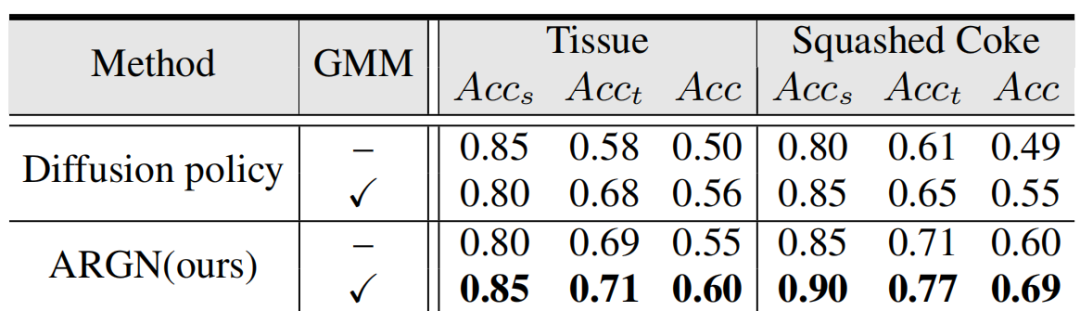

ARGN模块则聚焦于解决数据效率低和空间关系建模难的问题,通过递归计算构建空间记忆,同时引入自适应衰减机制和高斯混合模型(GMM),实现了高效且精准的运动生成。

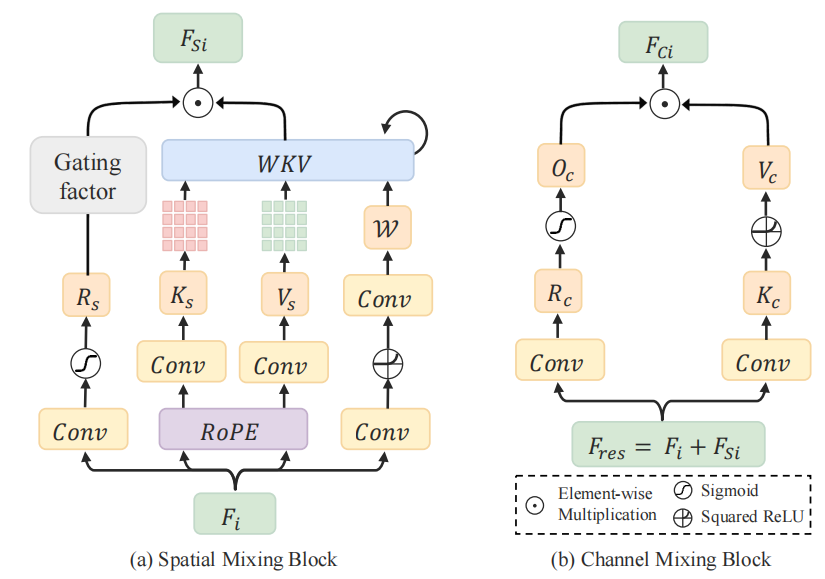

(a)空间混合块与(b)通道混合块的结构

为了建立图像斑块与机器人动作之间的关联,该模块采用旋转位置编码(RoPE),无需可学习的位置参数就能增强模型对相对空间偏移的敏感性。针对递归计算中容易出现的梯度消失问题,设计了自适应衰减机制,动态控制历史记忆的衰减速率,既能防止关键空间信息丢失,又能自适应放大任务关键斑块的权重。

在运动合成的最后阶段,ARGN摒弃了单一高斯模型容易回归均值、控制精度不足的缺陷,采用包含6个分量的高斯混合模型,分别对应六自由度机械臂的各个关节。通过期望最大化(EM)算法估计模型参数,利用马氏距离选择最匹配的动作聚类中心,最终输出精准的关节角度指令。实验证明,加入GMM后,ARGN在抓取压扁可乐罐任务中的准确率从0.60提升至0.69,性能提升显著。

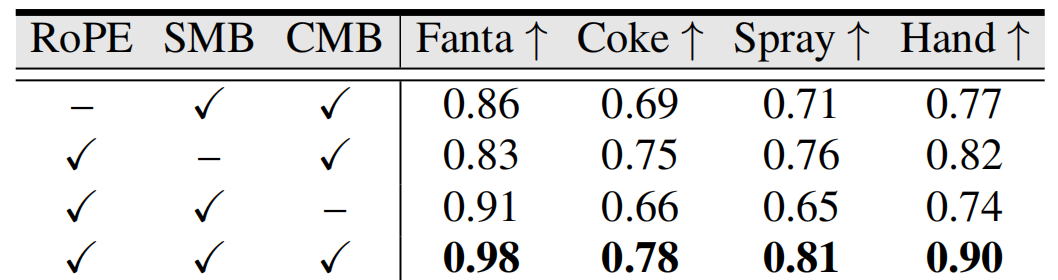

值得一提的是,ARGN的各组件协同效应明显。当RoPE、空间混合块和通道混合块同时启用时,模型在芬达罐、可乐罐、喷雾瓶和人类手部的抓取任务中均达到最高准确率,分别为0.98、0.78、0.81和0.90,充分体现了其架构设计的合理性。

▍实测封神:跨平台验证,性能全面碾压主流模型

为了充分验证RGMP框架的实用性,团队在人形机器人(聚焦上肢操控)和桌面双臂机器人两大平台上开展了全面测试,不仅与ResNet50、Transformer等经典架构对比,还挑战了Maniskill2冠军方案、Octo、OpenVLA等当前主流的机器人操控模型。

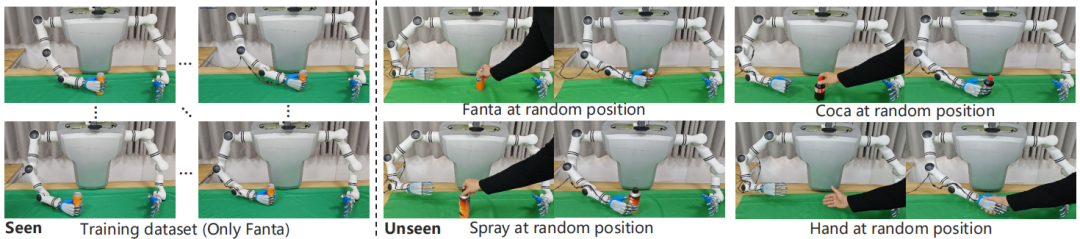

RGMP的泛化操控能力

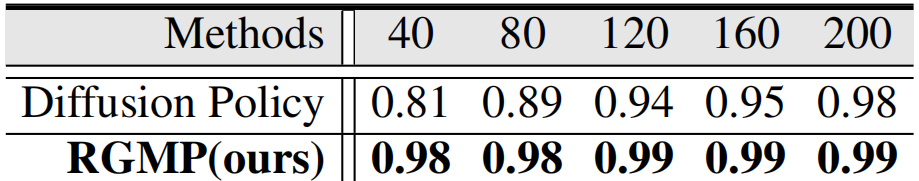

在泛化能力测试中,研究人员仅用40条芬达罐抓取演示样本训练模型,随后让其执行可乐罐、喷雾瓶、人类手部等未见过目标的操控任务。

结果显示,RGMP的平均抓取准确率达到0.87,远超Diffusion Policy的0.70、Dex - VLA的0.77,更是大幅领先于Maniskill2 - 1st和OpenVLA等模型。即使是形状不规则的压扁可乐罐,RGMP的准确率也达到0.78,展现出强大的跨物体适配能力。

在数据效率方面,RGMP更是表现惊艳。仅用40条训练样本就实现了0.98的高准确率,而Diffusion Policy需要200条样本才能达到相同水平,这意味着RGMP的数据效率是当前最优方案的5倍。随着样本数量增加,RGMP的准确率稳定维持在0.98以上,展现出极佳的稳定性,为低成本训练机器人操控模型提供了可能。

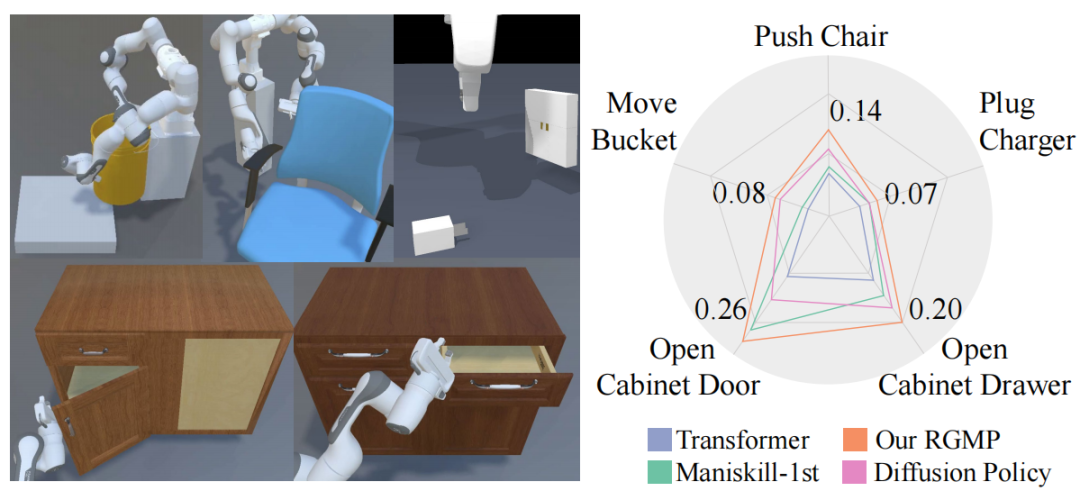

RGMP在Maniskill2仿真平台上的性能表现

此外,在Maniskill2仿真平台的五大复杂任务中,包括推椅子、移水桶、插充电器、开柜门和开抽屉,RGMP的平均得分达到0.15,远超其他对比模型的0.06 - 0.10。在开柜门任务中,其得分更是达到0.26,是部分模型的两倍多,证明该框架不仅适用于简单抓取,还能胜任复杂的复合操控任务。

▍结语与未来:

RGMP框架通过几何语义推理与递归高斯适配的深度融合,成功突破了现有机器人操控技术在泛化能力和数据效率上的双重限制。其创新点不仅在于两个核心模块的巧妙设计,更在于构建了一套从感知决策到运动执行的完整解决方案,为后续研究提供了可复用的技术范式。

团队在论文中表示,未来将进一步探索功能泛化能力,希望实现“举一反三”的效果,让机器人掌握一种核心物体的操控功能后,能够自动推断出其他物体的操控轨迹,彻底摆脱对海量演示数据的依赖。

论文链接:https://arxiv.org/pdf/2511.09141