阅读时间大约8分钟(3174字)

阅读时间大约8分钟(3174字)

2025-12-03 Meta放大招!15分钟视频,就能让机械臂学会开烤箱、擦桌子!

作者:李鑫 出品:具身智能大讲堂

当我们想象未来家庭中的机器人时,总会期待它们能像人类一样灵活处理日常琐事,按下烤面包机的开关、把玩具放进碗里、甚至轻轻旋转烤箱旋钮调节温度。但长久以来,这个看似简单的需求,却成了机器人领域的“老大难”问题:传统机器人要学会这些动作,不仅需要工程师在实验室里反复调试、采集海量专属数据,还得面对“人类动作无法直接适配机械结构”的天然鸿沟,导致大多数方案始终停留在实验室阶段,难以走进真实生活。

近日,来自纽约大学和Meta的研究团队提出的AINA框架,让机器人学习技能的方式发生了根本性转变:不需要任何机器人专属数据,也不用复杂的模拟训练,只要普通人戴上Aria Gen 2智能眼镜,随手拍一段15分钟的日常操作视频,多指机械臂就能“看懂”并学会这些动作,在烤面包机按压、烤箱开门、抽屉打开等9项日常任务中,成功率最高能达到86%,远超传统方案。

1►用智能眼镜当“桥梁”,把人类日常变成机器人教材

AINA框架的核心在于找到了一个“完美的数据载体”——Aria Gen 2智能眼镜。这款眼镜不是普通的消费级产品,它搭载了前置高清RGB摄像头、4个环绕式SLAM相机和多个IMU传感器,能实时捕捉佩戴者的头部姿态、左右手的3D关节位置,甚至能通过立体视觉计算出周围环境的深度信息。

这意味着,普通人戴着它做饭、整理家务时,眼镜就能自动记录下“人类如何操作物体”的完整数据:比如手指怎么握住烤面包机的杠杆、手腕怎么用力按下、物体在空间中的位置变化……这些数据既像网络视频一样“来自真实生活”,能覆盖各种场景,又比普通视频多了3D姿态、深度等“机器人能看懂”的关键信息,刚好补上了传统方案的短板。

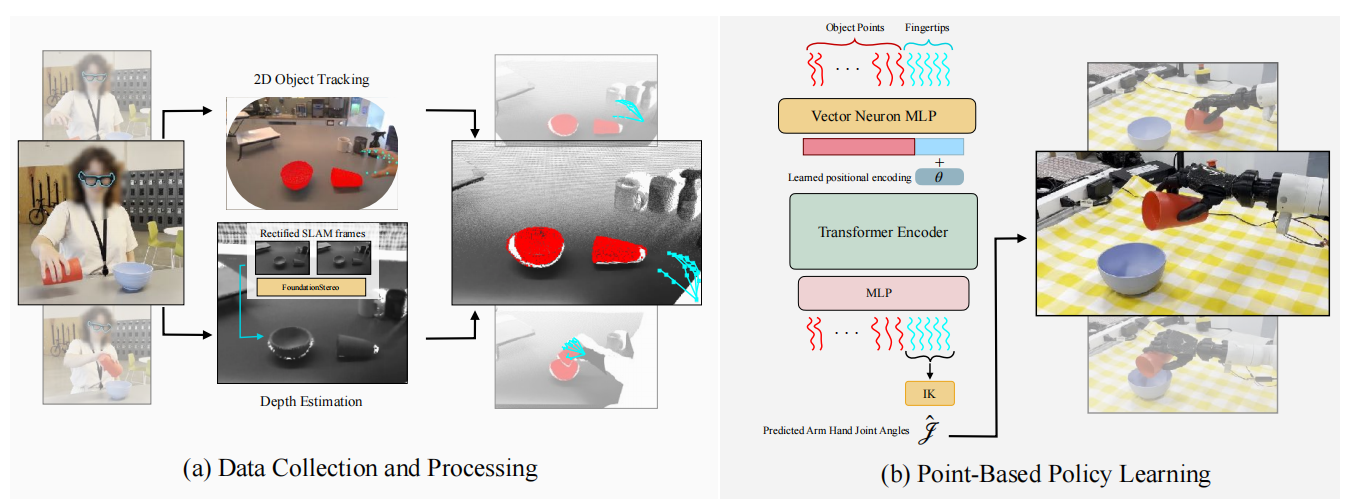

AINA 是一个从智能眼镜采集的野外人类数据中学习多指操作策略的框架,无需任何机器人数据(包括在线修正或模拟数据)。其工作流程如下:首先,人类佩戴 Aria 2 智能眼镜,在任意背景下的任意表面上采集野外演示数据(左侧流程);接着,在机器人部署环境中录制一段演示数据(中间流程);之后,基于点云的操作策略会被训练出来,并直接部署到机器人上(右侧流程)。平均仅需 15 分钟的人类视频采集工作,AINA 就能完成自主机器人操作策略的训练。

基于这个数据载体,AINA设计了一套完美的工作流程,让人类视频能顺畅转化为机器人技能:

AINA 整体框架示意图解析

图中左侧展示了数据的处理流程:人类手部姿态由 Aria Gen 2 智能眼镜直接提取,立体深度信息则通过周围的 SLAM(同步定位与地图构建)相机帧估算得出。这一处理过程为右侧的 3D 策略学习方法提供了关键支撑,使其既能顺利运行,又能对背景杂乱干扰保持鲁棒性(即不受背景干扰影响)。

第一步是“数据采集”,过程简单到几乎不需要专业知识。研究者让普通人戴着Aria Gen 2眼镜,在任意环境下演示目标动作——比如在自己家里打开抽屉、用海绵擦桌子,每个任务拍50条演示视频,总时长大概10分钟。之后,再去机器人所在的环境,用眼镜拍1条不到1分钟的“场景适配视频”——比如在机器人旁边的桌子上,再演示一次打开抽屉的动作。这么做的目的,是为了给后续的数据对齐找一个“参照物”。

第二步是“数据处理与对齐”,这是解决“人机场景差异”的关键。不同人演示时,桌子高度、站立位置可能不一样,直接用这些数据训练机器人会“水土不服”。AINA先通过Grounded-SAM模型,用文字提示(比如“抽屉”“海绵”)在视频里圈出目标物体,再用CoTracker跟踪物体在每帧的2D位置,结合眼镜计算出的深度信息,把2D位置转换成3D点云。接着,它会计算“场景适配视频”和“野外演示视频”中物体的位置差异,先平移、再旋转,把所有野外数据都“拉”到机器人的坐标系里,确保机器人看到的物体位置和人类演示时一致。

第三步是“训练与部署”,让机器人“学会”并“做到”。AINA采用了基于Transformer的3D点云模型,输入的是人类演示中“指尖的3D轨迹”和“物体的3D点云”,输出的是机器人未来要执行的“指尖轨迹”。训练时,模型会学习“人类手指怎么跟着物体动”——比如擦桌子时,指尖要始终贴住海绵、跟着海绵移动。为了让模型更鲁棒,研究者还会给数据加一些“干扰”,比如轻微平移物体位置、缩放大小,防止模型“死记硬背”。

部署到机器人时,AINA还要解决最后一个问题:把“指尖轨迹”转换成机器人的“关节角度”。因为机器人的机械结构和人类不同,直接按轨迹动会“卡住”。研究者专门设计了一套“逆运动学模块”,能根据机器人的关节数量、活动范围,自动计算出每个关节该转多少度,才能让指尖到达目标位置。针对“没有力反馈”的问题,他们还加了个小技巧:当模型预测的拇指和其他手指距离小于5cm时,就让机器人手指并拢,模拟人类抓取时的施力动作。

2►实验结果:九项任务碾压基线,3D点云是关键优势

为了验证AINA的效果,研究团队在9项日常任务中做了全面测试,还和目前主流的机器人学习方案做了对比,结果相当亮眼。

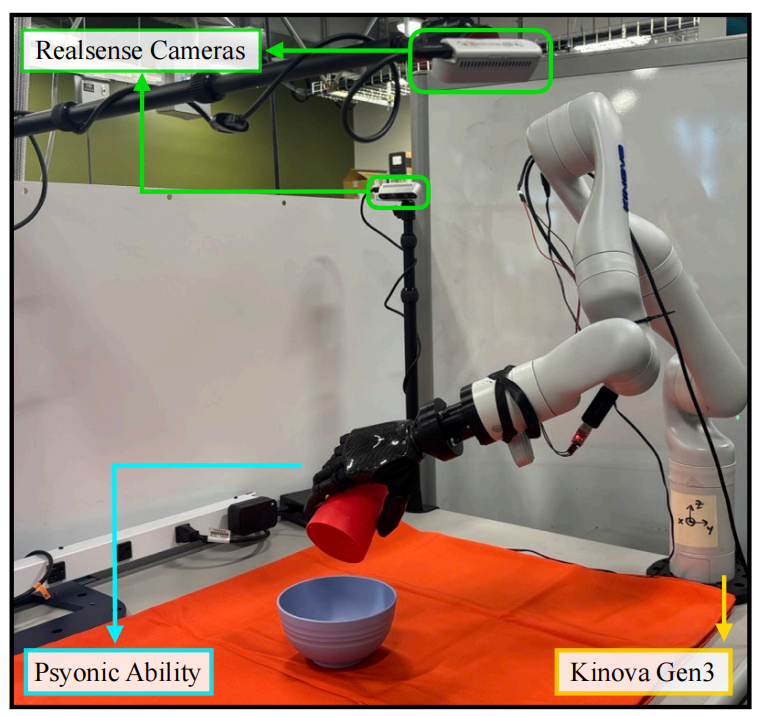

机器人实验装置示意图

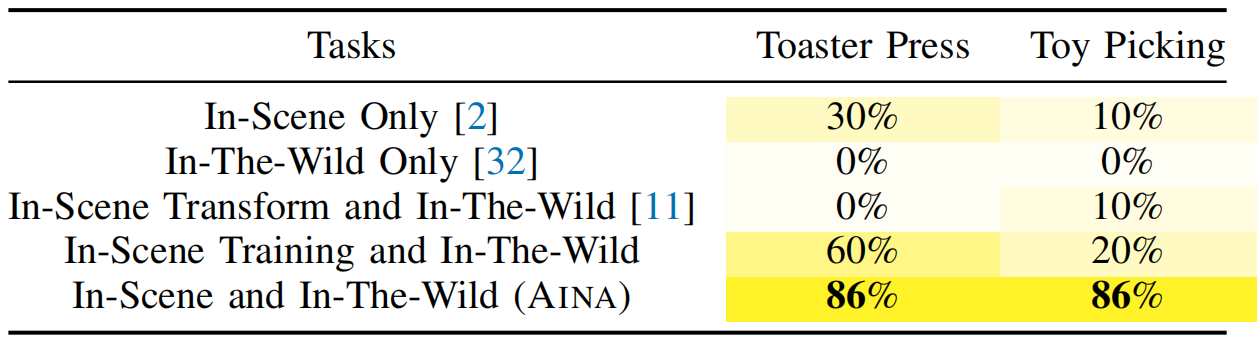

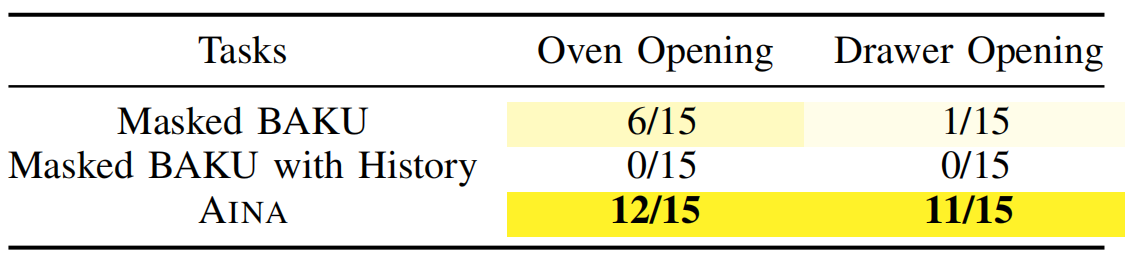

在“数据有效性”测试中,AINA的优势非常明显。比如“烤面包机按压”任务,只用地板场景数据的基线方案成功率只有30%,只用野外数据的方案成功率是0%,而AINA结合两种数据后,成功率直接冲到86%;“玩具拾取”任务也一样,从最高20%的基线成功率,提升到86%。

这说明,野外数据能让模型“见多识广”,适应不同场景,而场景数据能让模型“精准落地”,适配机器人的实际操作空间,二者结合才能发挥最大效果。

AINA 在九项任务中的机器人部署测试结果每项任务最左侧的列展示了(模型的)空间泛化能力。各类符号的含义在图下方有说明。虚线代表物体的朝向;若未标注虚线,则表示物体朝向与所展示的部署测试结果中的朝向一致。在 “打开烤箱” 任务中,研究团队还展示了 AINA 在存在背景干扰情况下的性能表现。

更关键的是,AINA在“3D点云 vs 图像”的对比中,展现出了压倒性优势。过去很多机器人学习方案用RGB图像当输入,但人类演示时头部会动,导致图像视角和机器人固定相机的视角差异很大,模型很容易“看懵”。

基于 RGB 图像的基线模型中所用 BAKU 框架 [54] 的示意图。其中,指尖编码器采用多层感知器(MLP),图像编码器则为在 ImageNet 分类任务上预训练的 ResNet-18 模型 [55]。动作令牌(action token)被设置为零向量。

在“烤箱开门”任务中,基于图像的Masked BAKU方案只成功了6次(共15次尝试),而AINA成功了12次;“抽屉打开”任务里,图像方案只成功1次,AINA成功11次。原因很简单:3D点云关注的是物体的空间位置,不管视角怎么变,点云的相对关系是稳定的,而图像很容易受视角、光照影响。

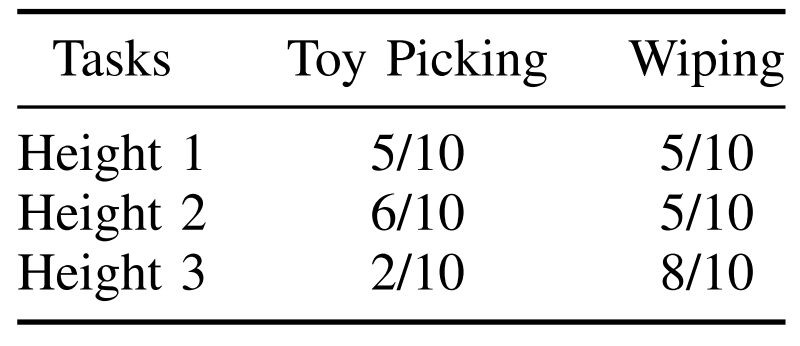

高度实验示意图。每个黄色托盘的高度为 3.5 厘米。高度 1 由 2 个托盘堆叠而成,高度 2 由 4 个托盘堆叠而成,高度 3 由 5 个托盘堆叠而成。因此,高度 1 的场景与初始部署场景最为接近,而高度 3 的场景与初始部署场景差异最大。

在更贴近真实生活的“高度适配”测试中,AINA也表现出色。研究者在机器人的操作台上叠了不同数量的盘子,模拟不同高度的桌子——从2个盘子(7cm高)到5个盘子(17.5cm高)。在“擦拭”任务中,AINA的成功率始终保持在50%-80%;“玩具拾取”任务虽然在最高高度时成功率降到20%,但原因是当时的场景演示视频里,人类把玩具放得太靠近碗,导致模型“学偏了”,并非框架本身的问题。

玩具拾取、烤面包机按压及擦拭任务的泛化实验

而在“物体泛化”测试中,AINA展现出了一定的灵活性:如果换一个形状相似的物体,比如用新的烤面包机替代旧的,用白色橡皮替代海绵,它依然能正常工作;但如果物体形状、重量差异太大,比如用爆米花包装替代软玩具,它就会“手足无措”,这也成了未来需要改进的方向。

3►不完美但有突破性:AINA离实用还有三道坎

尽管AINA的表现已经远超此前方案,但研究团队也坦诚地指出了它的三个局限性。

第一个是“缺乏力反馈”。人类操作时会靠触觉调整力度,比如拿鸡蛋时会轻轻捏,但Aria眼镜只能捕捉视觉和姿态信息,没法记录“力”。这导致机器人在处理易碎品、软质物体时,可能会出现用力过猛或握不住的情况。未来可能需要结合肌电传感器、测力手套等设备,补充触觉数据。

第二个是“相机时序错位”。Aria眼镜的RGB相机和SLAM相机快门时间有细微差异,如果佩戴者头部动得太快,会导致图像里的物体位置和深度信息对不上,影响3D点云的准确性。目前研究者只能让数据采集者尽量慢一点动,未来需要更鲁棒的3D跟踪算法来解决这个问题。

第三个是“设备适配问题”。现在训练用的是Aria眼镜的数据,部署时用的是Realsense相机,两种设备的参数有差异,导致机器人看到的“物体位置”和训练时略有不同。虽然影响不大,但要实现更精准的操作,还需要让训练和部署用的设备数据保持一致,目前研究者正在优化Aria眼镜的实时深度估计功能。

4►结语:机器人“学徒”时代或许不远了

AINA的意义,不止在于提出了一个技术方案,更在于它改变了机器人学习的“范式”。过去,机器人学技能需要人类“上门教”——工程师到机器人所在的场景里采集数据、调试参数;而现在,人类只要“正常生活”,戴个眼镜拍段视频,就能把自己的技能“教”给机器人。这种“低成本、易规模化”的方式,让机器人走进家庭、服务普通人的梦想,又近了一步。

论文地址:https://arxiv.org/pdf/2511.16661

项目地址:https://aina-robot.github.io/