阅读时间大约8分钟(2875字)

阅读时间大约8分钟(2875字)

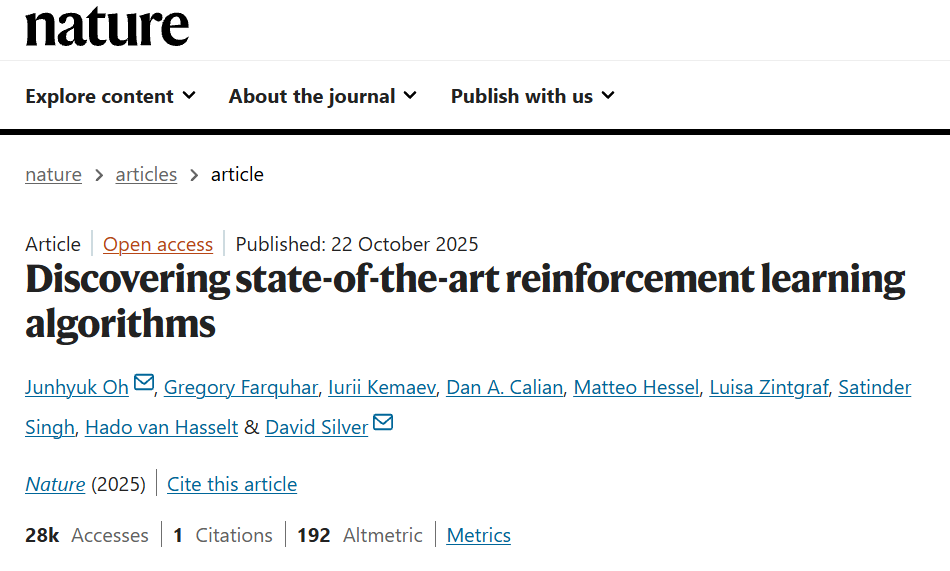

2025-12-09 Nature见刊发表!谷歌DeepMind发现了迄今最先进的强化学习算法!

作者:李鑫 出品:具身智能大讲堂

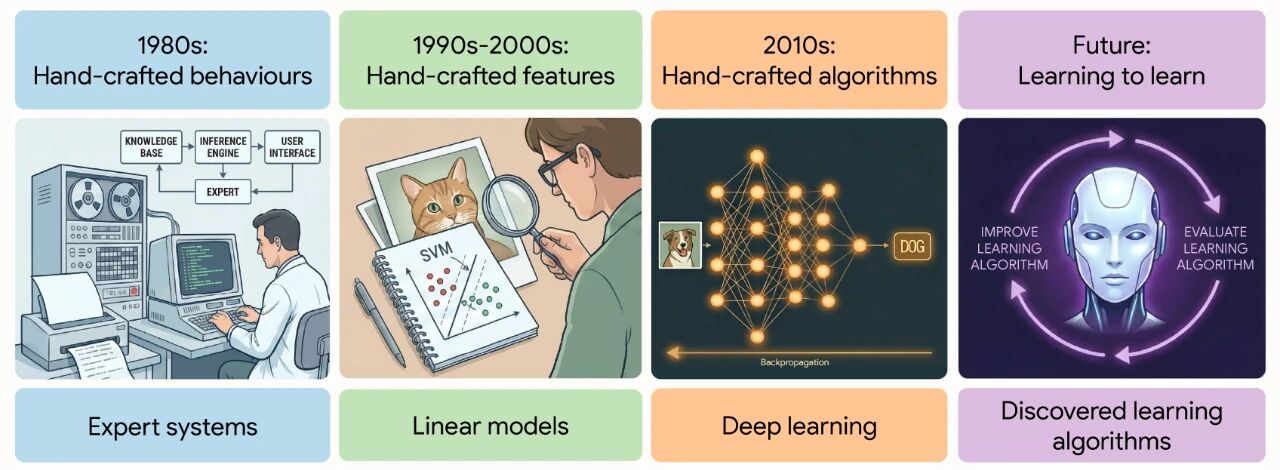

在人工智能领域,强化学习(RL)算法的设计长期依赖人类专家的知识积累与直觉判断。从AlphaGo背后的蒙特卡洛树搜索,到掌控复杂物理系统的深度强化学习框架,每一次算法突破都离不开研究者们耗时数年的反复迭代与调试。

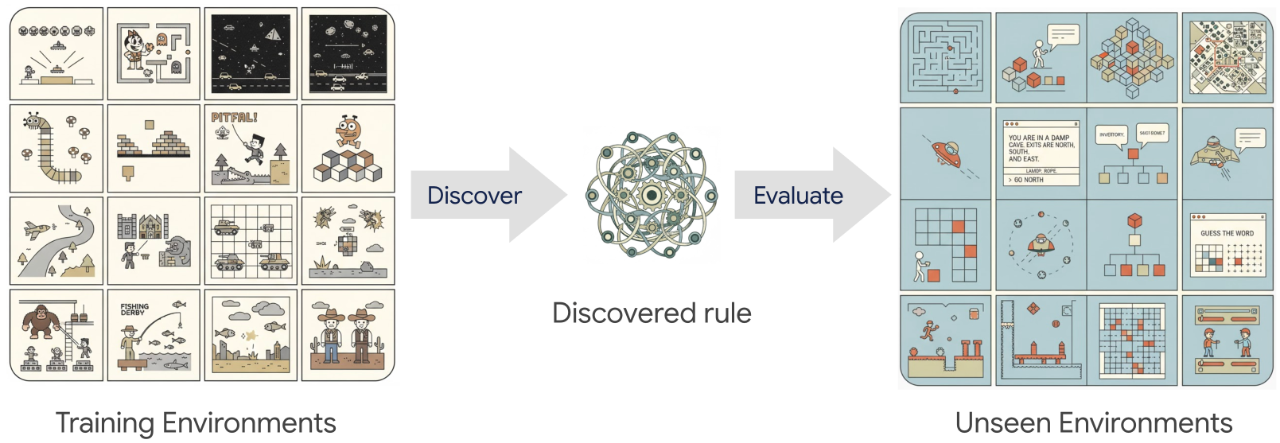

近日谷歌DeepMind宣称发现了最先进的强化学习算法,该算法拥有独特的预测语义与自适应机制,在 Atari 等多类经典基准任务上性能超越 MuZero 等人类设计算法,且具备优异的跨领域泛化能力。目前该研究成果已发表在《Nature》期刊。

1►AI为何要自主掌握“学习方法”?

强化学习的核心是让智能体通过与环境的交互,不断调整行为策略以最大化累积奖励。几十年来,研究者们手动设计了一系列经典算法:从基于时序差分的TD学习,到兼顾探索与利用的Q学习,再到如今广泛应用的近端策略优化(PPO)和分布式强化学习(Distributional RL)。这些算法在围棋、星际争霸等复杂任务中取得了瞩目成就,但人工设计的局限性也日益凸显。

首先,手动设计过程缓慢且繁琐,每一个算法改进都需要大量实验验证,严重依赖研究者的领域经验;其次,人类直觉往往存在偏见,难以探索到非常规的算法结构;更重要的是,传统算法的通用性有限,在某类环境中表现出色的方案,在新场景下可能需要重新调整甚至推倒重来。尽管此前已有研究者尝试自动发现学习算法,但要么局限于超参数优化等窄范围搜索,要么仅在网格世界等简单环境中验证,始终无法替代人工设计的主流算法。

谷歌DeepMind团队意识到,解决这一问题的关键在于让机器像生物进化那样,通过大量试错和经验积累自主探索学习规则。他们提出的核心思路是:构建一个能够表征广泛强化学习规则的搜索空间,让系统通过多代智能体在复杂环境中的交互经验,元学习(Meta-Learning)出最优的强化学习更新规则。

2►核心框架:如何让AI“发明”强化学习算法

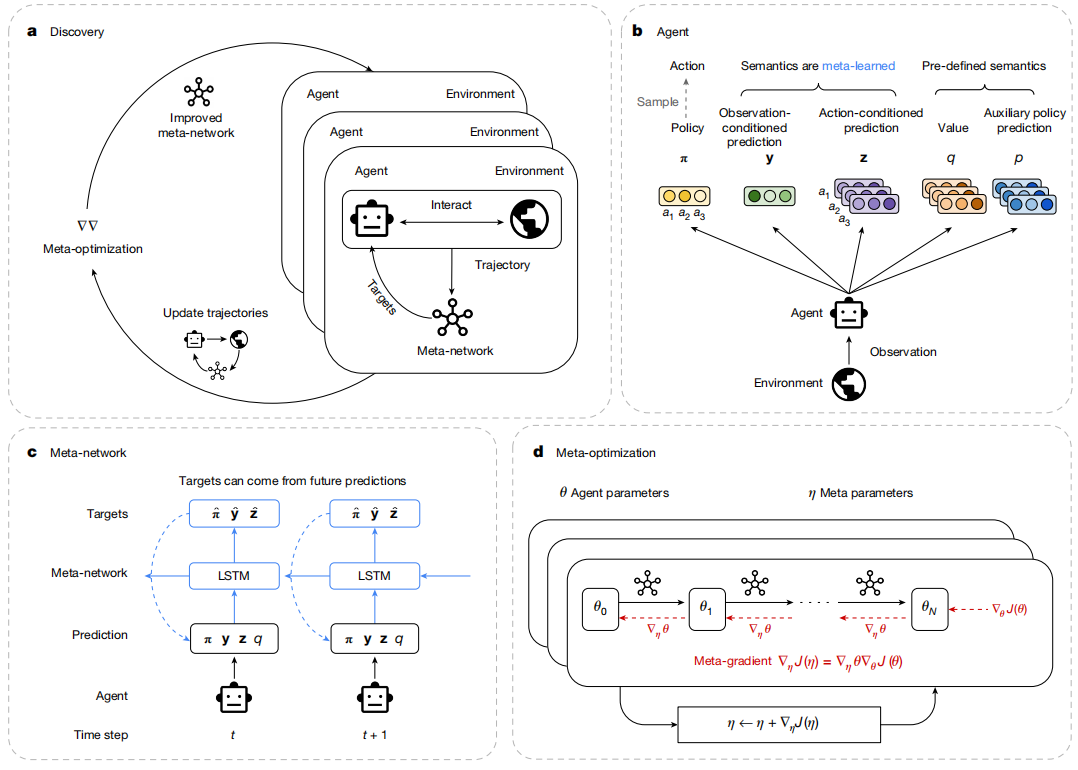

DiscoRL的发现过程主要依赖两个关键组件:智能体网络(Agent Network)和元网络(Meta-Network),以及两层优化机制(智能体优化与元优化),整个框架如同一个“算法进化实验室”。

从智能体群体中发现强化学习规则

灵活的搜索空间设计

传统强化学习算法的核心是更新规则——即如何根据未来奖励和预测结果,调整智能体的策略和预测目标。DiscoRL没有预设这些规则,而是定义了一个极具表达力的搜索空间:智能体除了输出传统的策略(π)和动作价值(q),还会产生两个无预定义语义的预测向量:观测条件预测y(s)和动作条件预测z(s,a)。这种设计既保留了现有强化学习的核心概念,又允许系统探索全新的预测语义和更新逻辑。

元网络则承担了“算法设计者”的角色,它通过长短期记忆网络(LSTM)处理智能体在一段时间内的交互轨迹(包括观测、动作、奖励和终止信号),为智能体的策略和预测向量生成更新目标。值得注意的是,元网络不直接接收原始观测数据,而是通过智能体的输出间接感知环境,这使得发现的算法能够轻松迁移到不同观测空间和动作空间的环境中。

双层优化机制

整个系统的运行分为两个层面:智能体优化和元优化,形成了“智能体学习任务,元网络学习如何让智能体更好学习”的闭环。

在智能体优化层面,每个智能体根据元网络生成的目标,通过最小化KL散度等距离函数更新自身参数,这与传统强化学习的训练过程类似,但更新目标由元网络动态生成而非人工预设。

在元优化层面,系统会维护一个智能体种群,让它们在多样化的复杂环境中并行交互。通过元梯度下降(Meta-Gradient Descent)方法,系统会根据所有智能体的累积奖励表现,迭代更新元网络的参数,使得生成的强化学习规则能够让智能体在各类任务中获得更好的性能。为了保证搜索的有效性,团队还引入了熵正则化和KL散度约束等机制,防止预测向量过早收敛或策略更新过于激进。

大规模训练与环境设计

与此前仅在简单环境中进行元学习的工作不同,DiscoRL的训练环境覆盖了多个经典强化学习基准,包括57款Atari游戏、16款程序性生成的ProcGen游戏和30个DMLab任务。这些环境具有不同的动力学特征、奖励结构和观测空间,能够全面考验算法的通用性。

DiscoRL的评估结果 a–f

训练过程中,系统会实例化大量智能体并行交互:Disco57(基于Atari环境训练)使用128个智能体循环遍历57款游戏,Disco103(融合Atari、ProcGen和DMLab)则使用206个智能体。整个训练依托JAX框架和TPU集群实现,Disco57需1024个TPUv3核心运行64小时,Disco103则需要2048个TPUv3核心运行60小时,这种大规模并行计算确保了系统能够高效探索广阔的算法空间。

3►实测碾压:在经典基准上超越人类设计算法

DeepMind团队在多个权威基准上对DiscoRL进行了全面评估,结果显示,这款机器自主发现的算法在性能和通用性上均达到了state-of-the-art水平。

Atari基准:刷新历史最佳

Atari 2600游戏集是强化学习领域最具代表性的基准之一,包含57款需要复杂策略规划和长期信用分配的游戏,被誉为“强化学习算法的试金石”。在这一基准上,Disco57取得了13.86的四分位均值(IQM),超越了MuZero、Dreamer等所有人类设计的经典算法。更值得注意的是,Disco57的训练效率显著更高,达到MuZero的最终性能仅需约40%的计算资源,展现出更优的算法结构。

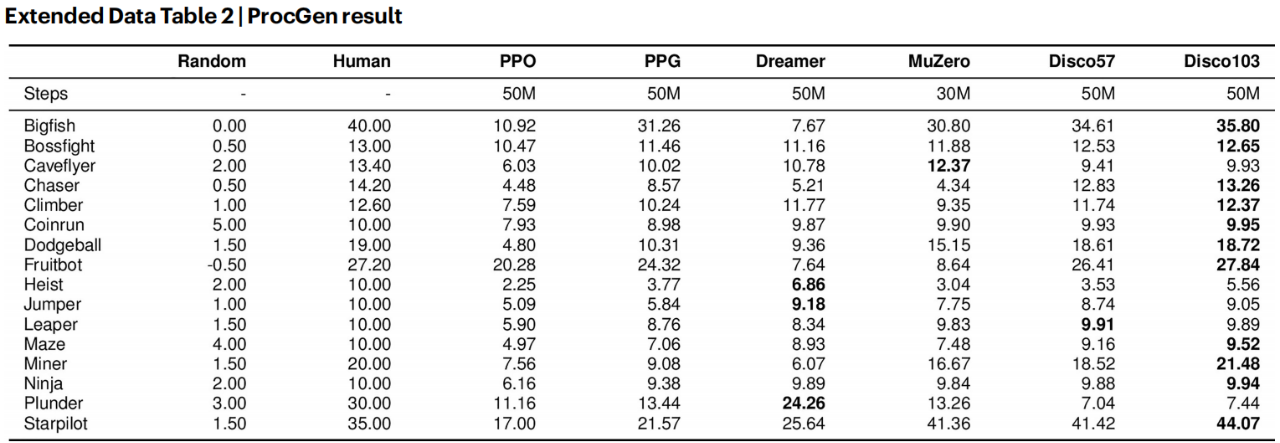

跨领域泛化:未见过的环境也能表现出色

通用性是衡量强化学习算法的关键指标。Disco57在训练过程中从未接触过ProcGen、NetHack等基准,但在这些“陌生环境”中依然表现惊艳:在ProcGen的16款程序性生成游戏中,它超越了PPO、MuZero等算法,部分游戏达到人类水平。

ProcGen基准测试结果

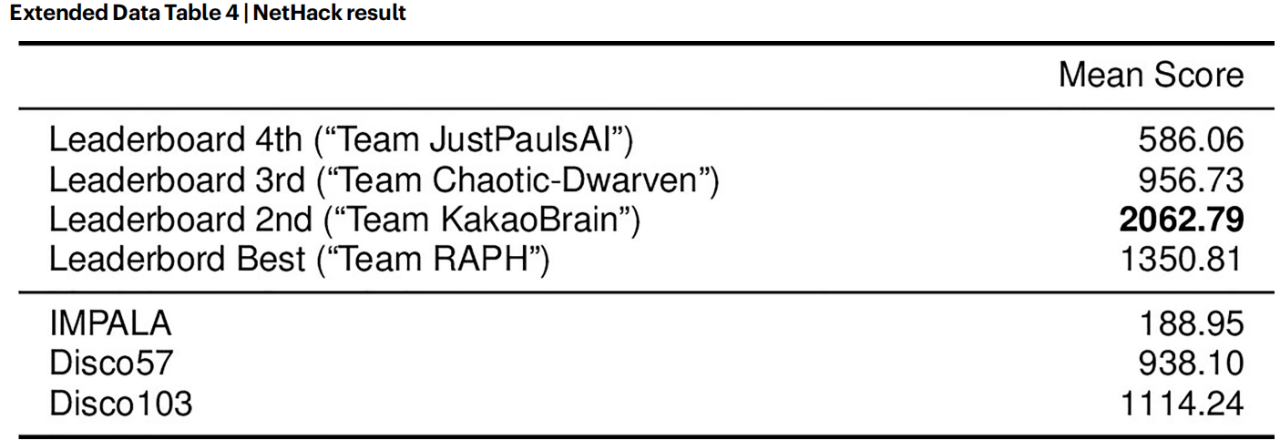

在有40多支团队参与的NetHack NeurIPS 2021挑战赛中,Disco57未使用任何领域特定知识,仅凭通用学习规则就获得了第三名。

NetHack基准测试结果

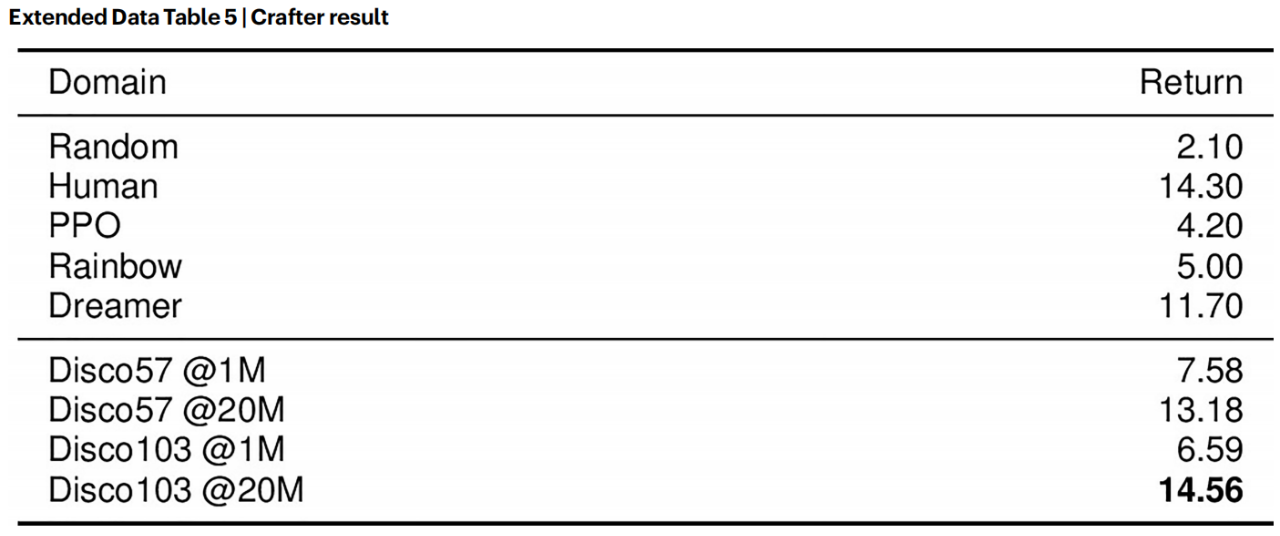

在需要掌握多种生存技能的Crafter基准中,它在2000万步训练后达到13.18的平均回报,接近人类水平(14.30)。

环境多样性增益:数据越多,算法越强

研究团队发现,DiscoRL的性能和通用性与训练环境的复杂度和多样性正相关。

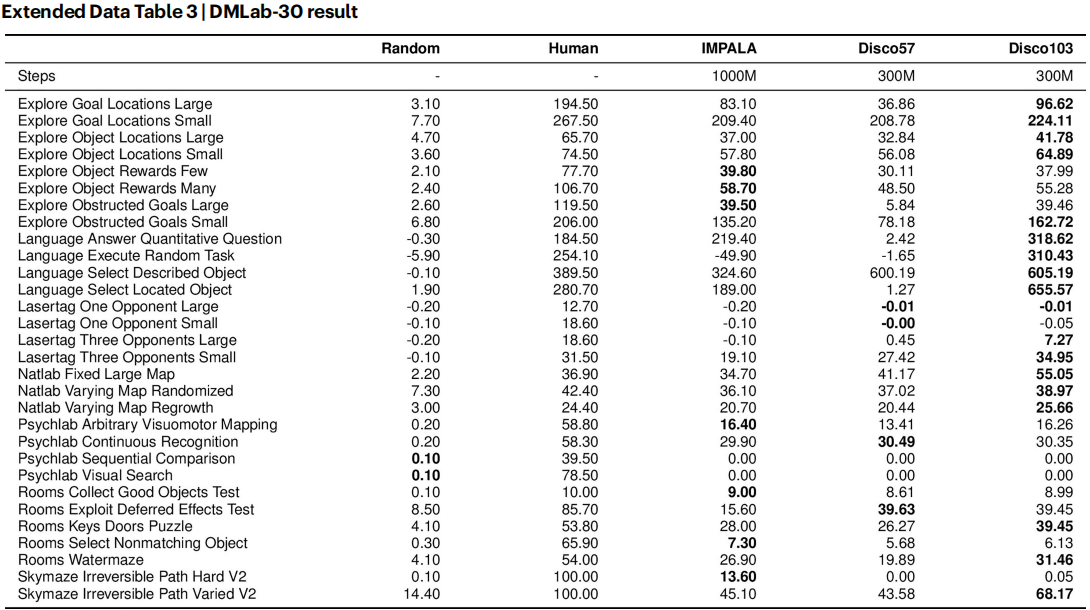

DMLab-30基准测试结果

Disco103通过融合Atari、ProcGen和DMLab的103个环境进行训练,不仅在原有环境中保持了Disco57的优秀表现,还在所有跨领域基准上进一步提升:在Crafter中达到人类级性能(14.56),在Sokoban(推箱子)任务中接近MuZero的state-of-the-art水平。

Crafter基准测试结果

相比之下,仅在57个网格世界简单环境中训练的版本,在Atari基准上的性能大幅下降,证实了复杂多样环境对算法发现的重要性。

4►算法揭秘:机器发现了什么独特机制?

通过对DiscoRL的深入分析,研究团队发现这款机器自主设计的算法包含了一些与人类设计截然不同的关键机制,这些机制正是其性能优势的核心来源。

独特的预测语义

DiscoRL的预测向量y和z发展出了全新的语义功能:它们能够提前感知到显著事件(如即将获得的大额奖励、策略熵的变化),并聚焦于环境中对未来有重要影响的物体(如远处的敌人),这与传统价值函数关注即时收益、策略关注当前最优动作的特点形成互补。信息分析显示,这些预测向量包含了关于未来奖励和策略熵的独特信息,能够为决策提供更全面的依据。

自适应引导机制

元网络通过处理多步未来轨迹生成更新目标,形成了一种自适应的引导机制。实验表明,当扰动未来时间步的预测输入时,当前目标会发生显著变化,证明DiscoRL采用了比传统算法更灵活的引导策略。这种机制允许智能体根据环境动态调整学习重点,而无需人工预设引导方式。

预测与策略的深度融合

与传统算法中将辅助任务与策略更新分离的做法不同,DiscoRL的预测向量直接参与策略更新过程,为方差缩减提供了更有效的基线。实验显示,如果禁用这些预测向量或阻止其引导策略更新,算法性能会大幅下降,证实了这种深度融合设计的有效性。

5►结语与未来:

DiscoRL的突破不仅是强化学习领域的重要进展,更标志着人工智能从“人类设计”向“自主进化”迈出了关键一步。它证明了机器能够自主发现超越人类设计的复杂算法,打破了“算法设计必须依赖人类专家”的固有认知。同时,DiscoRL能够通过多样化环境训练获得跨领域适应能力,该研究建立的“环境多样性驱动算法进化”也为未来算法发现提供了可复制的框架。

正如论文结尾所指出的:“高级人工智能的强化学习算法,未来可能不再由人类设计,而是由机器从自身经验中自动发现。”这一天,正在加速到来。

期刊地址:https://www.nature.com/articles/s41586-025-09761-x

项目地址:https://google-deepmind.github.io/disco_rl/