阅读时间大约8分钟(2838字)

阅读时间大约8分钟(2838字)

2025-12-15 重磅!字节跳动Seed团队提出全新共享自主框架,50种不同物体抓取成功率逼近90%!

作者:李鑫 出品:具身智能大讲堂

让机械臂搭配灵巧手实现类人级的精细操作,一直以来都是困扰行业的核心难题,尽管VLA模型在柔性技能学习上展现出一定的潜力,但高质量训练数据的稀缺始终制约着技术落地。

近日字节跳动Seed团队提出了一套全新的共享自主框架,通过人类VR遥操作与AI灵巧手控制,不仅解决了数据采集效率问题,更实现了端到端的臂手协同控制,在50余种物体(含未见过的物体)上达成近90%的抓取成功率,为通用机器人的灵巧操作提供了全新解决方案。目前该研究成果已发表在arxiv预印本。

1►字节跳动Seed团队提出共享自主框架 实现人机协同

字节跳动Seed团队发现,机械臂与灵巧手的运动特性存在本质上的差异,机械臂侧重大范围、长距离的宏观定位,而灵巧手则需要精细、合规的微观操作,传统一刀切的控制模式难以兼顾两者需求。

为解决上述问题,字节团队提出"人类控臂、AI控手"的共享自主框架。人类操作员通过VR接口专注于宏观控制,借助直观的VR遥操作系统,负责机械臂的避障、定位等长距离运动。该系统基于相对运动映射原理,支持90fps刷新率和低于100ms的低延迟,能将人类手部动作实时转化为机械臂的目标姿态,通过逆运动学求解确保运动流畅自然。

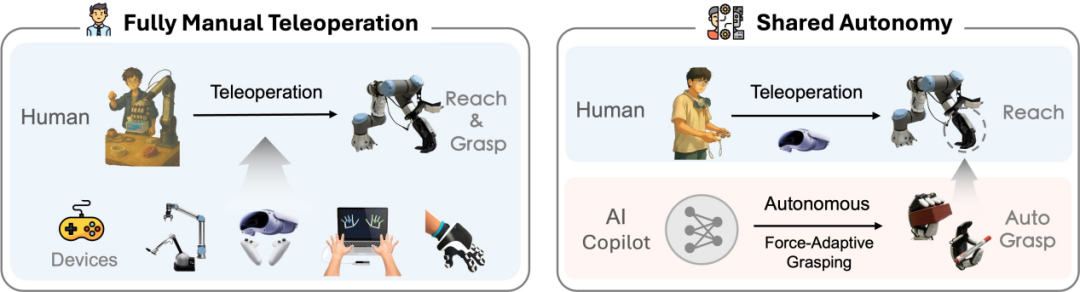

纯手动遥操作与所提出的共享自主模式(半自主遥操作)的对比

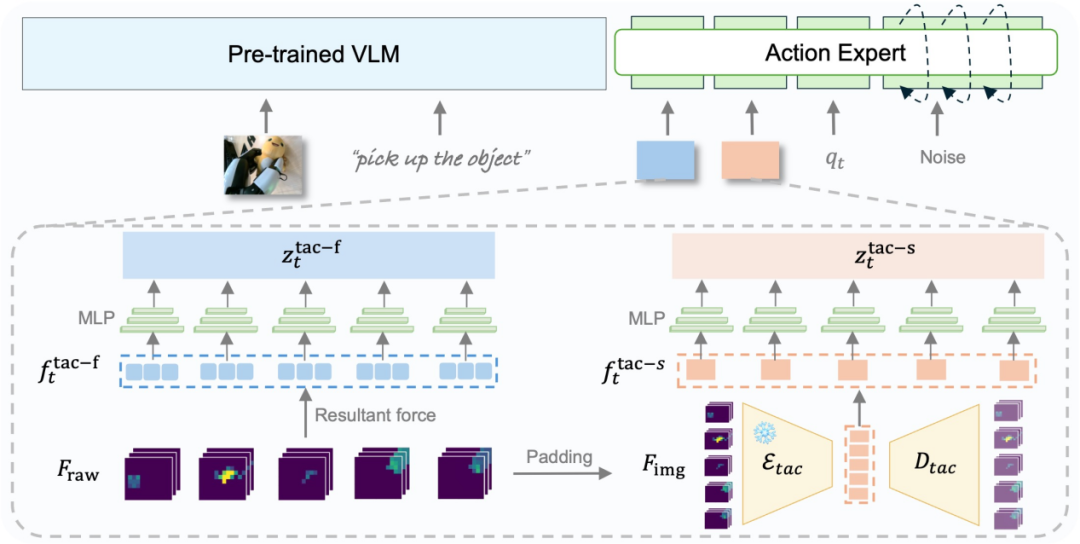

而AI则担任"灵巧手副驾",DexGrasp-VLA策略负责灵巧手的精细抓取控制。该策略融合了视觉、语言、触觉和本体感受多模态反馈,其中触觉反馈包含两个关键特征——指尖合力向量(捕捉接触力的大小和方向)和空间触觉嵌入(通过卷积自编码器提取接触分布模式),实现力自适应抓取。

该分工彻底消除了人类操作员的认知负担,无需再同时协调复杂的臂手系统,仅需专注于宏观路径规划,而AI则通过多模态感知精准处理微观抓取动作,最终实现高质量、高效率的臂手协同示范数据采集。

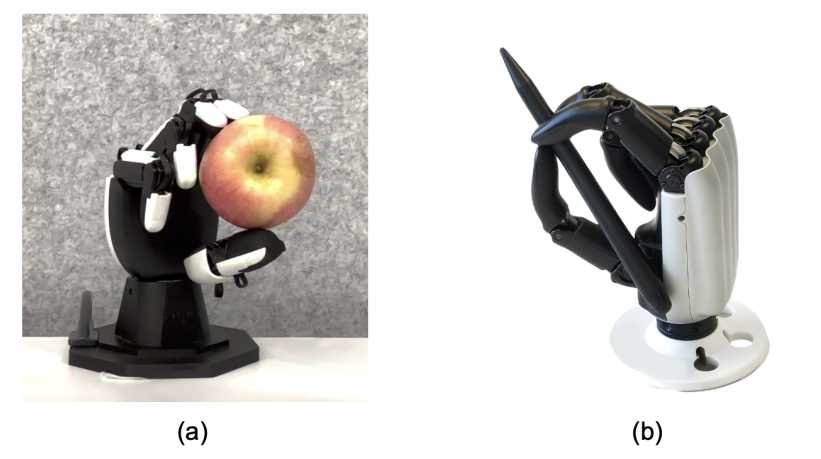

用于验证共享自主框架(以训练端到端 VLA 模型)的两款不同灵巧手:(a)星动纪元XHAND1 灵巧手 [2];(b)RY-H2 灵巧手 [1]

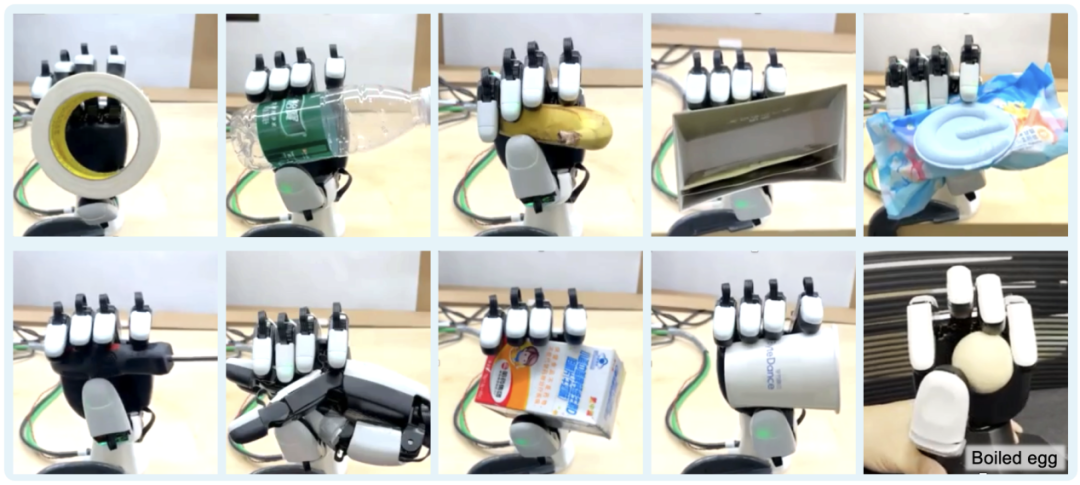

值得注意的是,该框架的核心执行部件采用了星动纪元的全直驱XHand1五指灵巧手。这款12全主动自由度的五指灵巧手在指尖配备了270°环绕式触觉阵列传感器,每个指尖拥有120个三维力传感通道,能提供超高分辨率的接触几何和分布力感知数据。支持位置、力和混合力-位置控制模式,控制频率达83Hz,指尖握力范围15N-80N,既可以实现精细的脆弱物体抓取,也能完成强力夹持,且100万次抓取的使用寿命完全满足大规模数据采集和测试的需求。此外,研究团队还在11自由度的RY-H2灵巧手上验证了框架的通用性,同样取得了明显的性能提升。

2►VLA 框架实现在桌面清理任务中实现95.5%灵巧抓取

仅仅解决数据采集问题还不够,字节跳动团队在策略训练架构和持续优化机制上进行了多重创新,确保最终模型的性能与鲁棒性。

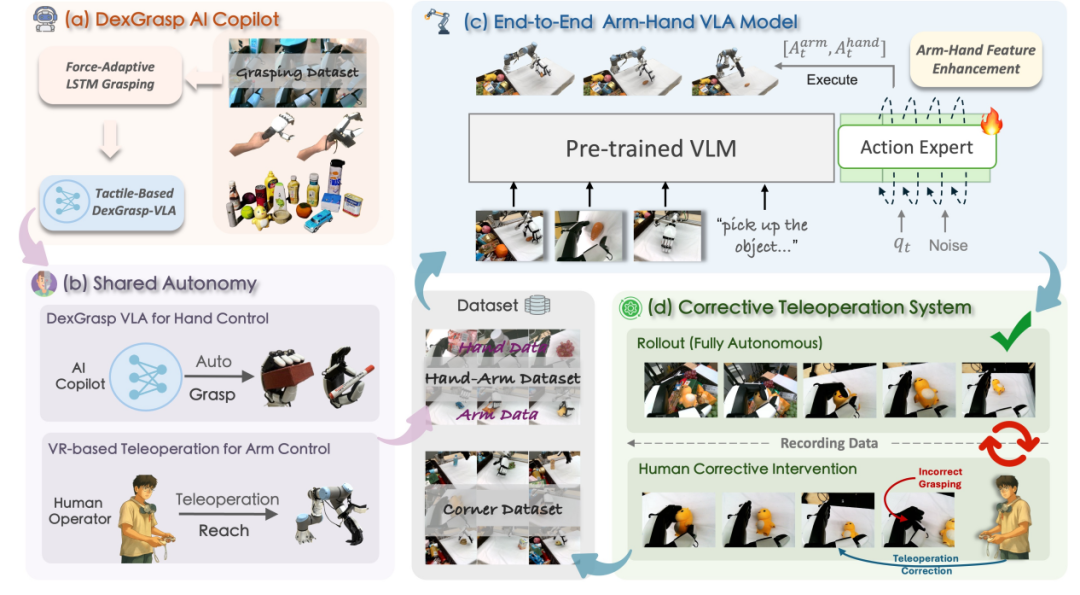

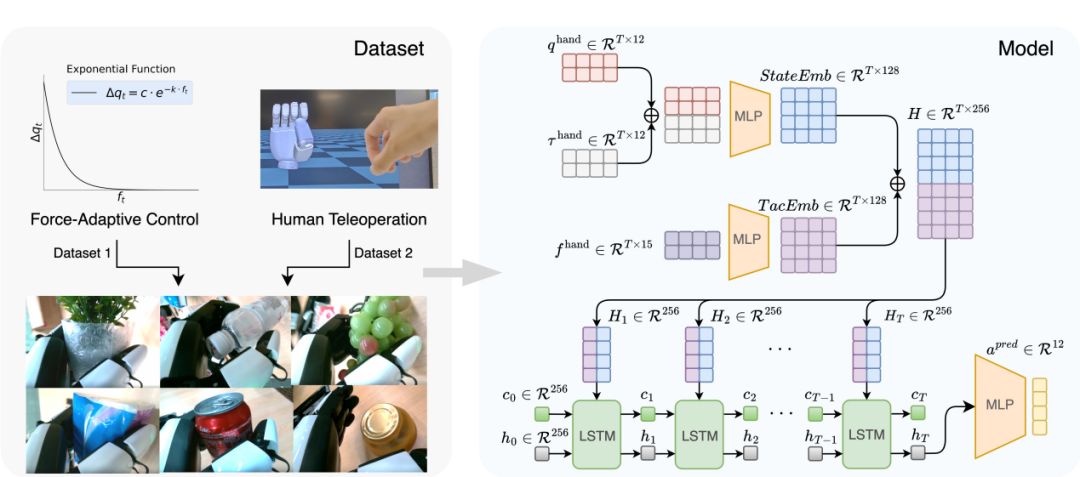

DexGrasp-VLA 策略及臂 - 手 VLA 策略的数据采集与训练流程

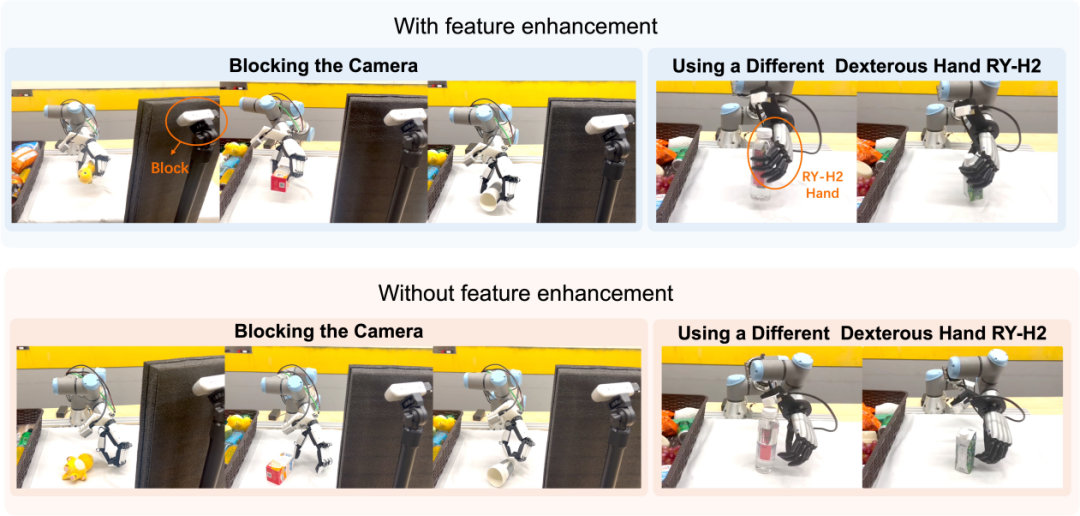

针对臂手运动的本质差异,团队设计了Arm-Hand Feature Enhancement模块,该模块在预训练VLA模型的基础上,新增了两个专用编码器。其中一个是共享任务表征,负责保留基础VLA模型从视觉、语言和状态输入中编码的全局任务信息,另一个则是臂专用编码器与手专用编码器,二者分别提取宏观运动(臂)和微观操作(手)的专属特征,并通过辅助损失函数强化各自的运动特性,这种设计让模型既能理解全局任务上下文,又能精准捕捉臂的流畅定位和手的合规抓取特性,在视觉遮挡等恶劣条件下仍能保持稳定性能。

基于 LSTM 的力自适应抓取策略数据采集与训练框架

灵巧手的力自适应抓取能力源于DexGrasp-VLA分层训练策略,第一阶段聚焦训练基于LSTM的“盲抓”策略,该策略仅依赖本体感受和触觉反馈,从68条参数化力控轨迹与150条人类遥操作轨迹中学习,能够实现无视觉依赖的力自适应抓取。

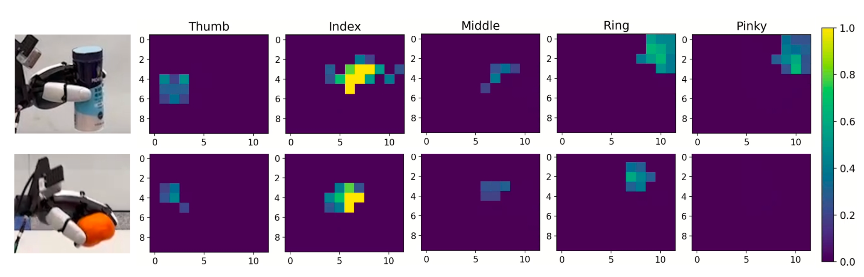

基于触觉的 DexGrasp-VLA 手部控制方案

第二阶段则进一步融合视觉与语言信息,研究团队利用LSTM策略自主采集的180条抓取轨迹,训练出具备场景理解能力的多模态VLA策略,使其能够在杂乱环境中精准响应语言指令并完成目标抓取。

为应对真实场景中的长尾问题,团队构建了Corrective Human-in-the-Loop Teleoperation人机闭环纠错系统,该系统在自主运行阶段,策略成功执行的轨迹会被自动记录为正向示范数据,这些数据中也包含了XHand1灵巧手完成精细抓取等操作的有效轨迹;当系统遇到未见过的物体形状、adversarial配置或环境干扰导致失败时,便进入故障干预阶段,此时人类操作员可通过共享自主接口实时介入,纠正错误并完成任务,进而生成故障恢复轨迹。

而在迭代优化阶段,正向数据与恢复数据会共同用于策略的增量微调,逐步提升模型对复杂场景和边缘案例的适应能力。实验结果显示,经过50条定向姿态故障轨迹和50条极端场景轨迹的微调后,策略在复杂配置下的成功率明显提升,彻底解决了初始模型对特定姿态和边缘案例的处理短板,这也让配备该策略的灵巧手在复杂环境中的操作可靠性进一步增强。

3►实验验证:50+物体近90%成功率 多场景泛化能力突出

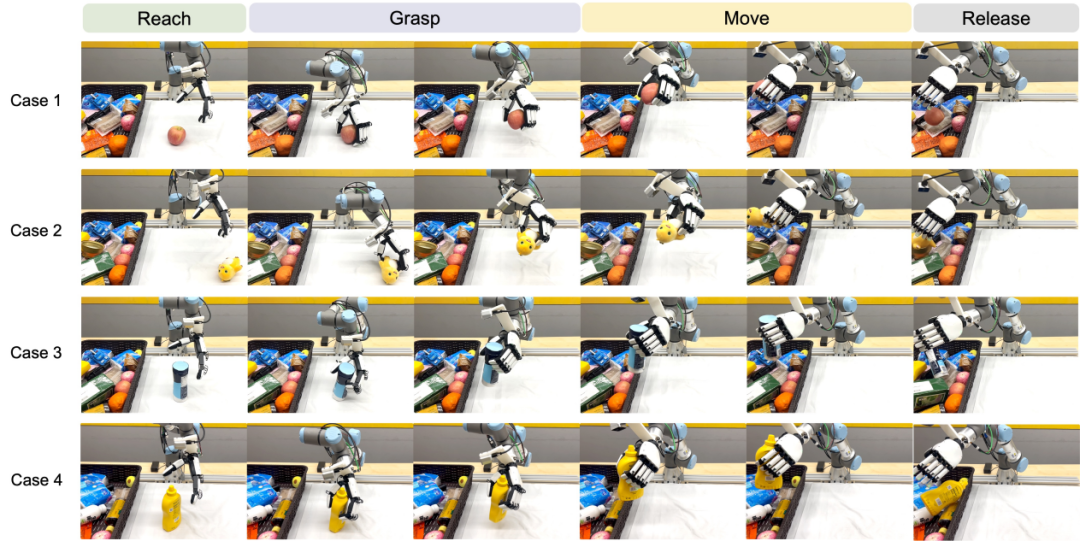

团队在 UR3e 协作机械臂搭配 XHand1 灵巧手的硬件平台上开展了全面实验验证,该平台配备 3 台 RGB-D 相机(两台固定用于全局观测,一台腕部安装提供近距离操作视觉反馈),确保多模态感知的完整性。

集成机器人系统的硬件配置:(1)灵巧操作器:搭载全直驱五指12全主动 自由度 星动XHAND1灵巧手的 6 自由度 UR3e 协作机械臂,具备指尖触觉感知功能,可实现柔顺操作;(2)感知套件:3 台 RGB-D 相机(2 台固定、1 台腕部安装),分别用于全局场景感知与近距离视觉观测。

核心性能方面,端到端臂手VLA策略在20种见过的物体上实现91.7%的抓取成功率,在30余种未见过的物体上成功率达85.6%,平均成功率88.7%,覆盖不同形状、尺寸、重量和材质的物体。

鲁棒性测试当中,在右侧相机被遮挡的恶劣视觉条件下,配备臂手特征增强模块的策略仍保持58%的成功率,而基线模型仅为19%。

此外对比欠驱的RY-H2(11-DoF:6主动+5欠驱动,无触觉);,算法能够更充分地利用全直驱 星动XHAND1 (12-DoF全主动,270°环绕触觉阵列(120点));的多关节灵活性,实现更自然的协调动作。

星动XHAND1提供的高保真触觉反馈是实现鲁棒抓取的必要条件。当视觉被剥夺时,正是星动XHAND1的触觉传感器阵列提供了维持稳定抓握所需的信息。

实验数据显示:无触觉: 成功率仅为21%。仅有触觉合力反馈: 成功率提升至70%。合力反馈+空间触觉分布: 成功率高达90%。

这种高成功率直接来源于星动XHAND1的两个特性:高灵敏度触觉: 能够精确感知与易碎品接触时的微小力变化。高精度位控: 能够根据触觉反馈,精确输出目标位置,避免捏碎物体。

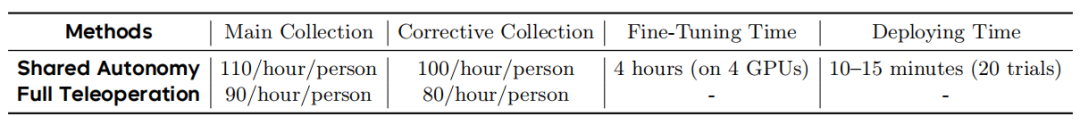

数据效率方面,共享自主框架让单操作员每小时可采集 110 条主数据集轨迹,相比全手动遥操作提升 25%,corrective 数据采集效率达 100 条 / 小时,4 小时即可完成一次策略微调,20 次评估仅需 10-15 分钟,实现快速迭代。

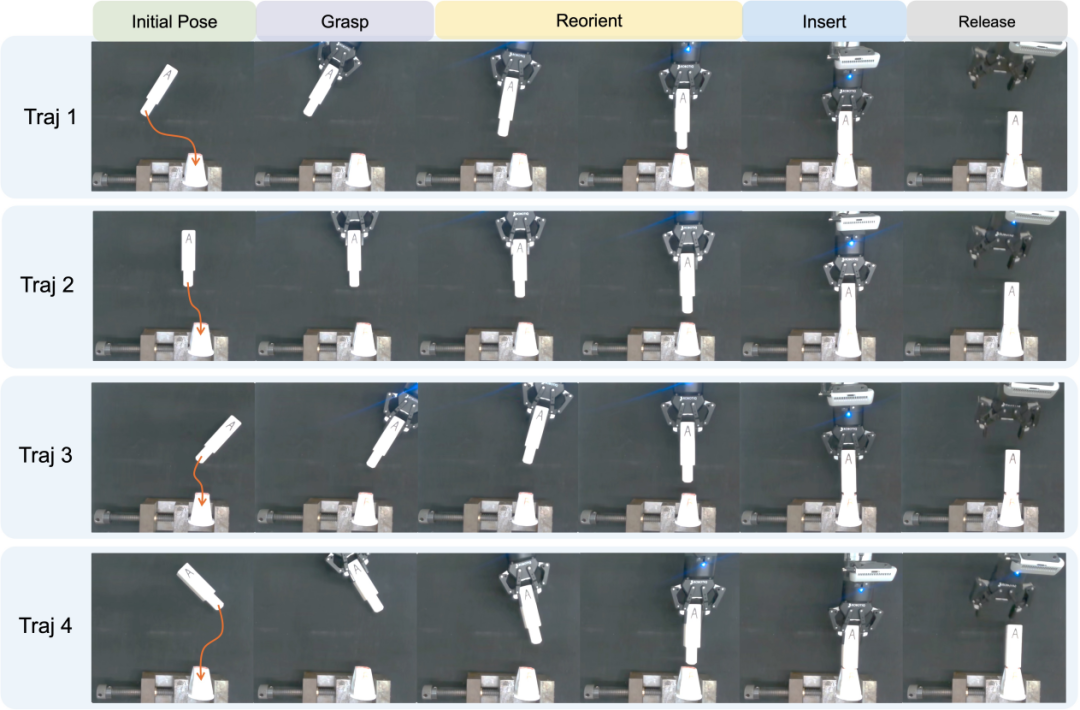

在拓展验证上该框架不仅适用于灵巧手抓取,还成功应用于长周期任务(如钢笔 relocation、药盒包装、瓶子扶正)和工业装配任务(如 peg-in-hole 插入),在工业装配任务中成功率从70%提升至90%,在跨场景、跨硬件上展现出强大的泛化能力。

4►结语与未来:

字节跳动的这项研究极具突破性,核心价值不仅在于让机器人在 50 余种物体的抓取任务中实现了近 90% 的高成功率,更关键的是破解了通用机器人灵巧操作落地的三大核心难题:一是平衡了数据采集的效率与质量,通过人机协同的共享自主模式,在降低人工负担的同时,获取到高质量的协同演示数据;二是兼顾了系统的模块化与泛化能力,臂 - 手特征增强模块让模型能适配不同硬件与场景;三是打破了传统模型 “训练即冻结” 的局限,借助纠错式人机交互实现策略的持续迭代优化。

未来,团队将进一步拓展该框架的应用范围,覆盖物体重定向、插入操作、长周期任务等更多操作技能。同时,还将探索更先进的触觉表征学习技术,优化多模态感知融合效果,并研发自主错误检测与复合恢复策略,推动通用机器人在真实场景中更广泛地落地应用。

论文地址:https://arxiv.org/abs/2511.00139

项目地址:https://dexvla-seed.github.io/dex-vla/