阅读时间大约5分钟(1614字)

阅读时间大约5分钟(1614字)

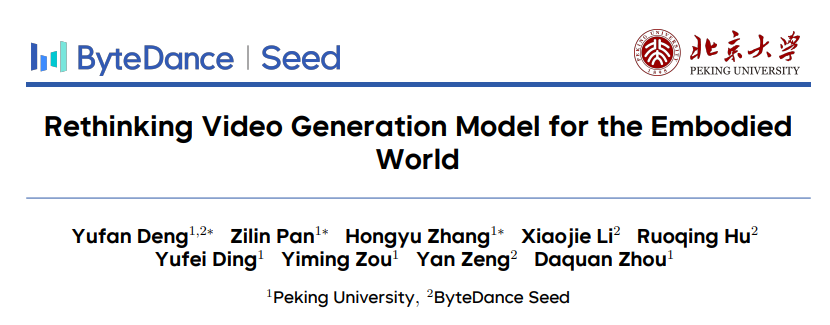

2026-01-26 北大 + 字节开源全球最大视频生成专用机器人数据集!含RBench基准、400万条标注片段!

作者:李鑫 出品:机器人大讲堂

视频生成模型已推动具身智能发展,能生成捕捉物理世界感知、推理和动作的机器人数据。但合成反映真实机器人交互的高质量视频仍有挑战,缺乏标准化基准导致难以公平比较和推进技术。

近日,北京大学与字节跳动Seed团队联合推出机器人视频生成基准RBench和开源数据集RoVid-X,相关研究成果已在arXiv发布,代码与数据集均已开源。

论文地址:https://arxiv.org/pdf/2601.15282

Huggingface:https://huggingface.co/papers/2601.15282

PART 01

机器人视频生成两大痛点亟待解决

扩散模型和视频生成技术取得突破,已应用于3D场景、自动驾驶、世界建模等领域,且逐渐用于机器人学习、动作预测和轨迹合成,缓解大规模人类遥操作数据短缺问题。当前机器人视频生成的系统评估尚不完善。

现有评估多依赖感知指标,聚焦视觉质量;物理基准缺乏任务特定数据集和标准。评估常忽略任务完成度、动作目标一致性和物理可行性,导致生成视频存在不自然动作或未完成任务仍获高分。机器人交互数据长期受规模和多样性限制。现有数据集规模小于视觉或语言领域,且在环境、物体集、任务范围和机器人形态等方面分布较窄,多局限于特定机器人类型、低分辨率或有限任务,影响视频基础模型的泛化能力。

PART 02

5大子指标、650组样本 RBench 破解机器人视频评估难题

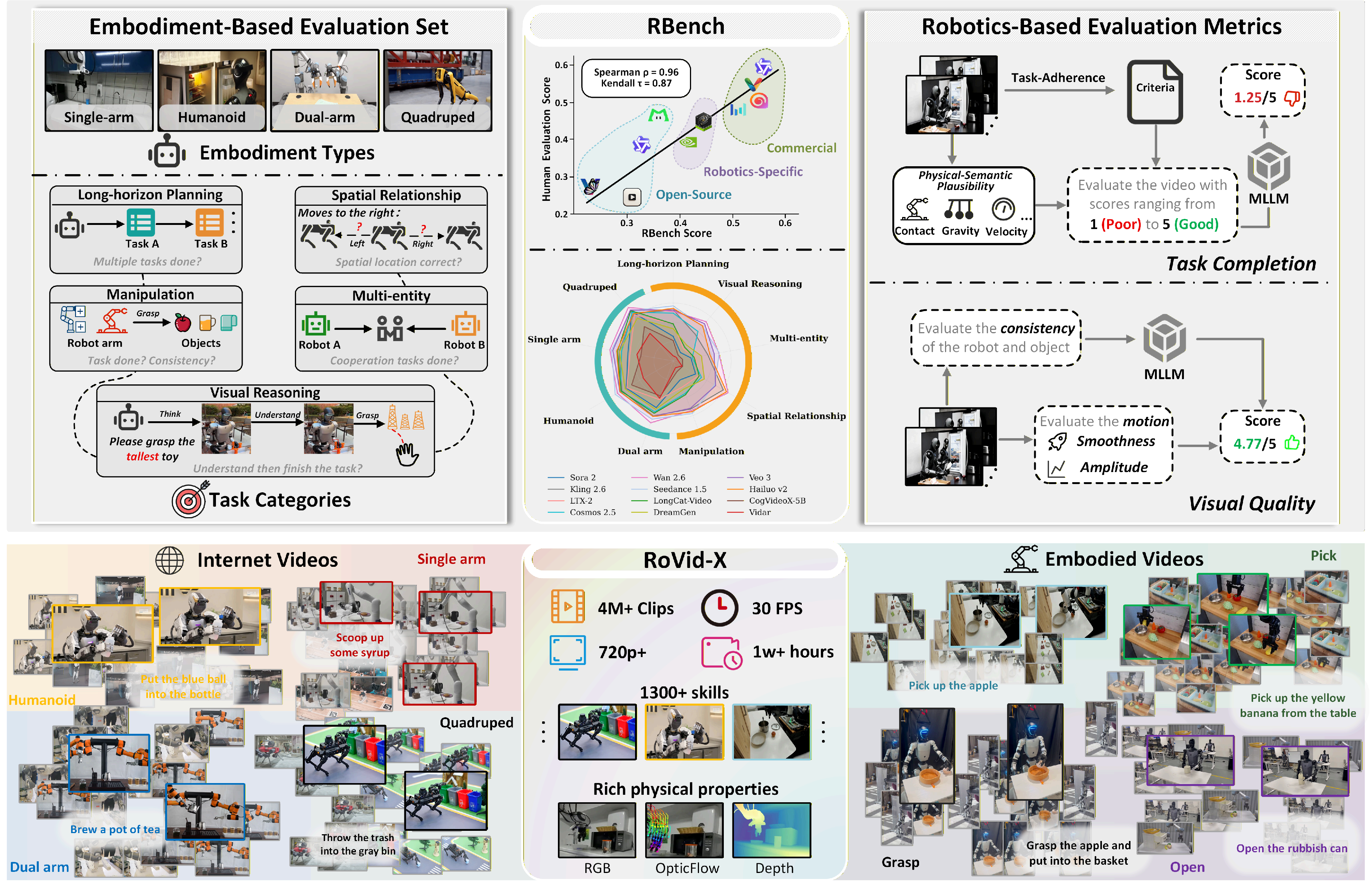

RBench是首个针对机器人视频生成的综合基准,含650组图文测试样本,覆盖五大任务领域和四类机器人形态。

任务领域包括常见操作、长程规划、多实体协作、空间关系和视觉推理,每类任务50个样本;机器人形态涵盖单臂、双臂、人形和四足机器人,每类100个样本。

样本源自公开数据集和优质网络视频,经人工验证准确性。通过重新设计任务提示、筛选数据源,避免与训练数据重叠,并记录操作物体、机器人类型、拍摄视角等元数据。RBench从任务完成度和视觉质量两维度评估,含五个精细化子指标。

物理语义合理性检测漂浮、穿透等物理违规;任务一致性验证视频是否贴合指令;机器人-物体稳定性确保机器人形态和物体属性全程一致;运动幅度避免无实际动作的无效视频;运动流畅度量化帧间连贯性。

评估采用MLLM作为零样本评估器,通过VQA-style协议打分。与人类评估的斯皮尔曼相关系数达0.96,自动评分与人类判断高度一致。

PART 03

25款模型实测 涵盖开源、商业、机器人三大类型

团队基于RBench评估25款主流视频生成模型,涵盖开源、商业和机器人专项三类。

商业模型占据前7名,Wan 2.6以0.607平均得分位列第一,Seedance 1.5 Pro、Wan 2.5紧随其后。表现最佳的开源模型Wan2.2_A14B排名第8,得分0.507,与顶尖商业模型存在差距。

消费级模型表现不及预期,Sora v2 Pro排名第17,平均得分0.362;Sora v1排名第22,得分0.266。这类模型优化目标为视觉观赏性,牺牲了物理精度和任务一致性。

所有模型在视觉推理和精细操作任务上表现薄弱。顶尖模型Wan 2.6在视觉推理任务中得分仅0.531;模型在单臂机器人精准抓握等精细操作任务上的得分,普遍低于四足机器人行走等粗粒度运动任务。

模型迭代与物理推理能力呈强相关性。Wan系列从Wan 2.1(排名14,得分0.399)到Wan 2.6(排名1,得分0.607),Seedance从1.0到1.5 Pro(排名从6升至2),性能大幅提升。机器人专项模型Cosmos 2.5虽落后于顶尖商业模型,但优于多数开源视频模型。而针对特定机器人实体微调的模型(如Vidar、UnifoLM)排名靠后。

PART 04

RoVid-X数据集 解决训练数据短缺难题

RoVid-X含400万条机器人视频片段,总时长超1万小时,分辨率均为720P以上,整合20余个开源数据集和多平台公开视频。

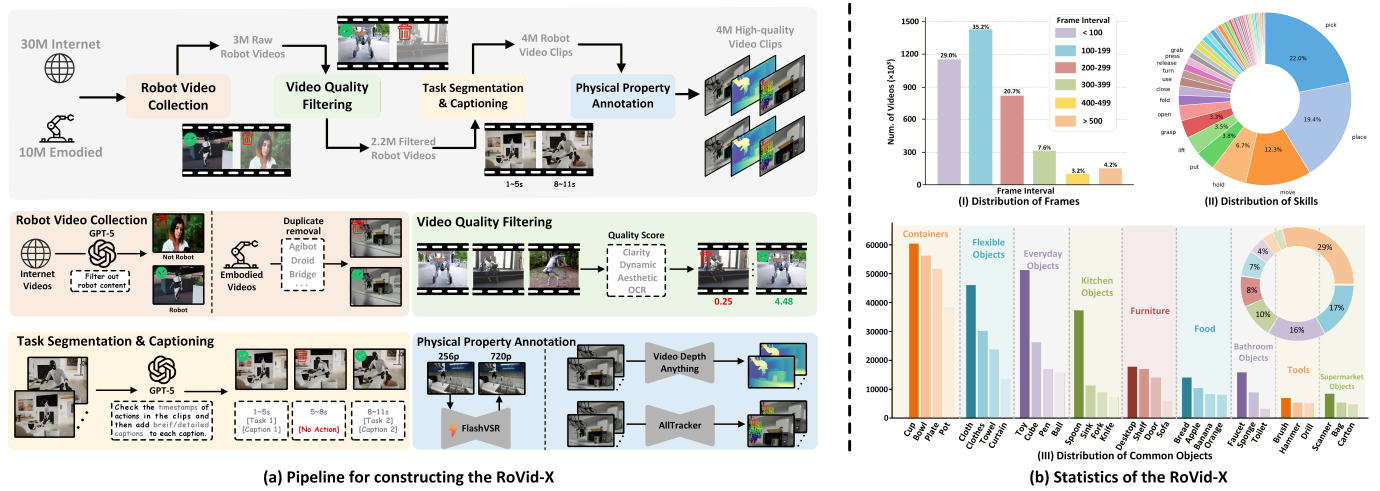

数据集通过四阶段流程构建:首先收集原始机器人视频,利用GPT-5过滤非相关内容,得到300万条原始素材;随后进行质量过滤,通过场景分割去除非机器人数据,从清晰度等多维度评分;接着进行任务分割与字幕生成,自动识别动作片段并生成标准化描述;最后进行物理属性标注,提升视频分辨率,标注光流和深度图等信息。

数据集涵盖1300+技能类型,支持第一/第三人称多视角,覆盖工业操作到日常协作各类场景,提供丰富物理交互先验和任务语义。

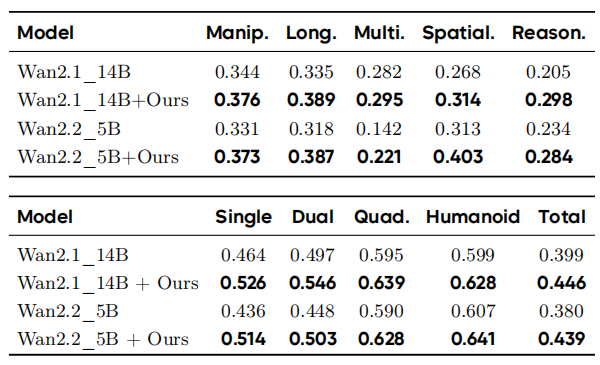

实验验证显示,用RoVid-X微调后的模型性能显著提升。Wan2.114B微调后单臂机器人任务得分从0.464提升至0.526,人形机器人任务从0.599提升至0.628,综合得分从0.399提升至0.446;Wan2.25B微调后综合得分从0.380提升至0.439。

PART 05

结语与未来

RBench项目页面、GitHub代码库及RoVid-X数据集已全部开源,开发者可通过HuggingFace获取数据集。团队未来计划利用逆动力学模型从生成视频中提取可执行动作,在仿真环境和真实硬件上进行闭环控制实验;开发更自动化、贴合物理规律的评估指标;训练物理能力更强的视频生成模型,生成高保真动作的机器人视频。