阅读时间大约10分钟以上(7256字)

阅读时间大约10分钟以上(7256字)

2025-05-16 下一个万亿市场?动作捕捉系统,或许将是人形机器人通向AGI的“核心基建”

作者:陈康成 出品:机器觉醒时代

1. 具身智能大模型的训练需要哪些类型的真机数据?

具身智能大模型的训练和成长需要大规模数据燃料的“喂养”。目前,所需的“数据燃料”主要有三种类型:互联网数据、合成数据以及真机数据。其中,真机数据质量最高,却获取成本高昂,但对于模型训练优化、性能评估改进、安全可靠性验证至关重要。因此,如何实现低成本、高效率的真机数据采集是人形机器人大规模量产前要解决的关键问题。

真机数据通常包括 机器人本体数据 和 环境感知数据 两大类型。

A. 环境感知数据

机器人环境感知数据是指机器人通过各类传感器(如摄像头、激光雷达、听觉传感器、力觉传感器等)采集的外部环境数据,涵盖静态场景(物体位置、形状、材质)和动态变化(移动物体轨迹、环境参数波动)。这些信息用于机器人理解周围环境、识别目标、规划路径及安全交互,是实现自主导航、避障、操作等功能的核心输入,支撑其在复杂场景中做出适应性决策,提升智能化水平。

物理环境数据:包括传感器直接感知的环境特征和环境物理属性。其中,传感器直接感知的环境特征包括摄像头拍摄的图像/视频(包含物体颜色、形状、位置、光照条件等)、激光雷达的点云数据(障碍物距离、尺寸、空间结构)、麦克风采集的环境声音(用于噪声检测或语音交互)等;环境物理属性包括地面粗糙度(通过力传感器或 IMU 振动数据推断)、温度/湿度、风力/气压等。

动态环境数据:移动物体轨迹(如行人、车辆的运动状态,通过视觉跟踪或雷达数据获取)、环境变化事件(如门的开闭、物体的摆放位置变化)。

交互相关环境数据:人机协作场景中人类的动作、手势(通过动作捕捉或视觉识别采集),或物体的物理特性(如重量、摩擦力,通过力传感器与运动数据融合推断)。

B. 机器人本体数据

本体数据是机器人实现精准控制(如轨迹跟踪)、状态监控(如故障预警)、算法训练(如动力学模型优化)的核心依据,通常包括运动学与姿态数据、动力学与力控数据、时间与同步元数据等。

运动学与姿态数据:包括关节运动数据(角度、速度、角速度等)、整体姿态与位置(躯干姿态、末端位置)等。

动力学与力控数据:包括关节动力学参数(电机扭矩、关节负载力/力矩)、地面反力与重心、惯性与碰撞数据等。

时间与同步元数据:时间戳与帧序号,用于确保数据时序一致性和可追溯性。

遥操作 和 动作捕捉 是常被提到的两种真机数据采集方式,但是两者之间既有区别,又存在关联,容易混淆。

两者之间的区别:二者均可作为数据采集手段,但动作捕捉可以理解成是 “专职数据采集工具”,而遥操作是 “控制过程中附带数据采集”。

在真机数据采集类型方面,动作捕捉主要采集运动学 / 动力学参数,服务于轨迹规划、仿真建模等。而遥操作侧重人机交互闭环数据,包含感知(环境 / 机器人状态)、交互(人机指令 / 反馈)、任务(目标达成度)三类数据,服务于远程控制策略优化、人机协同效率提升。

两者之间的关联:动作捕捉可独立使用(如记录机器人自主运动),也可作为遥操作的 “输入源”(机器人遥操作常用的实现方案有基于VR、外骨骼、动作捕捉设备等。),但二者核心功能分属 “数据层” 与 “控制层”。

接下来,文章将会详细介绍什么是动作捕捉?目前常见的动作捕捉系统数据采集方式有哪些,以及国内目前有哪几家企业在做具身智能机器人领域的动作捕捉解决方案。

2. 什么是动作捕捉系统?

在具身智能机器人领域,穿戴动捕设备的开发人员(演示人员)重复执行任务,执行过程中的每个动作将被动捕系统捕捉,并将人体动作转化为计算机能够处理的数字化的动作数据。

整个系统通过硬件设备捕捉运动信号,再由软件进行处理和分析,通过运动解算得到连贯的三维运动数据,最终输出目标参数,包括运动目标的三维空间坐标、人体关节的6自由度(3个平移+3个旋转)等,实现对人体动作的准确跟踪、记录以及重建人体关节的运动轨迹。

按技术原理的不同,动作捕捉系统可以划分为:机械式、声学式、电磁式、惯性式、光学式等五大类。但在具身智能机器人领域,光学式 和 惯性式是常用的两大主流技术路线。

1)光学式动捕系统

光学式动捕系统,顾名思义,基于光学原理完成物体的捕捉和定位。根据目标特征类型不同,光学式动捕系统可分为标记点式光学和无标记点式光学两类。日常谈到的光学式动作捕捉系统通常是指标记点式动作捕捉系统。

标记点式动捕系统工作原理:在运动物体的关键部位(比如,人体的关节处)粘贴反光或主动发光的标记点(Marker点),然后由多个动作捕捉相机(红外相机)从不同角度实时探测Marker点,数据实时传输至数据处理设备,根据三角测量原理精确计算Marker点的空间坐标。在连续视频帧中依据标记点运动连续性将不同帧坐标关联形成轨迹,针对人体捕捉,通过逆向运动学计算各关节旋转角度和位置完成骨骼绑定。

对于标记点式光学动捕系统又可进一步分为主动式光学动捕系统和被动式光学动捕系统两类。

主动式光学动捕系统:其标记点通常由小型的 LED 灯或其他发光元件组成,粘贴在运动物体的关键部位,这些标记点会按照一定的规律和频率主动发出特定波长的光(通常为红外线),以便于被光学传感器捕捉。每个标记点都有唯一的编码或标识,这样系统就能区分不同的标记点,从而准确地跟踪它们的位置和运动。但是,这些发光元件需要在运动物体表面安装电源进行供电,发光元件之间通过线缆连接。

被动式光学动捕系统:也称反射式光学动作捕捉系统,其标记点通常是反光材料的球体(如反光球),粘贴在运动物体关键部位,无需供电,由动作捕捉镜头上发出的LED照射光经反光球反射至动捕相机,进行标记点的检测和空间定位。

特点:光学动捕系统追踪精度高,亚毫米级别,能精准还原动作细节。但对场地要求严格,需要布置多视角相机,且易受物体遮挡,导致数据采集中断。此外,该系统价格高昂,这些特点使其应用场景受到一定限制。

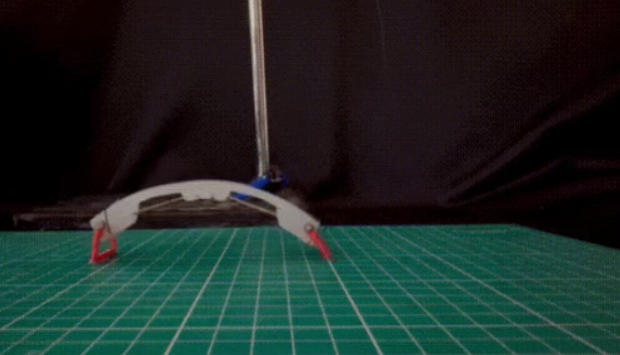

光学式式动作捕捉系统

2)惯性式动捕系统

惯性式动捕系统是通过惯性传感器完成物体的捕捉和定位,通过在人体关键部位穿戴惯性传感器,实时采集运动数据,经算法解算出各关节姿态角和空间运动轨迹的动作捕捉技术。

惯性式动捕系统通常由姿态传感器、信号接收器和数据处理系统组成。姿态传感器(惯性传感器)是惯性动捕系统的核心部分,通常由加速度计、陀螺仪和磁力计等多种传感器组成,固定于人体各主要肢体部位(手腕、脚踝或身体其他关键部位)。

信号接收器通常由无线电收发器或蓝牙模块等组成,它可以将姿态传感器测量到的数据通过无线信号传输到数据处理系统上进行处理。

数据处理系统将姿态传感器测量到的数据进行滤波、校准、以及运动解算融合等处理,并结合骨骼的长度信息和骨骼层级连接关系,重建出人体的运动轨迹和姿态变化,从而实现对人体运动的实时追踪。

特点:

缺点:惯性传感器本身不能进行空间绝对定位,存在漂移的问题,导致空间定位不够准确;对于快速运动和细微动作的捕捉有一定限制。

优点:系统不受遮挡影响,数据不容易中断,环境适应性强;便携性强、适用于室内和室外等环境;原理简单,操作容易,成本可控,在大规模场景下应用更有优势。

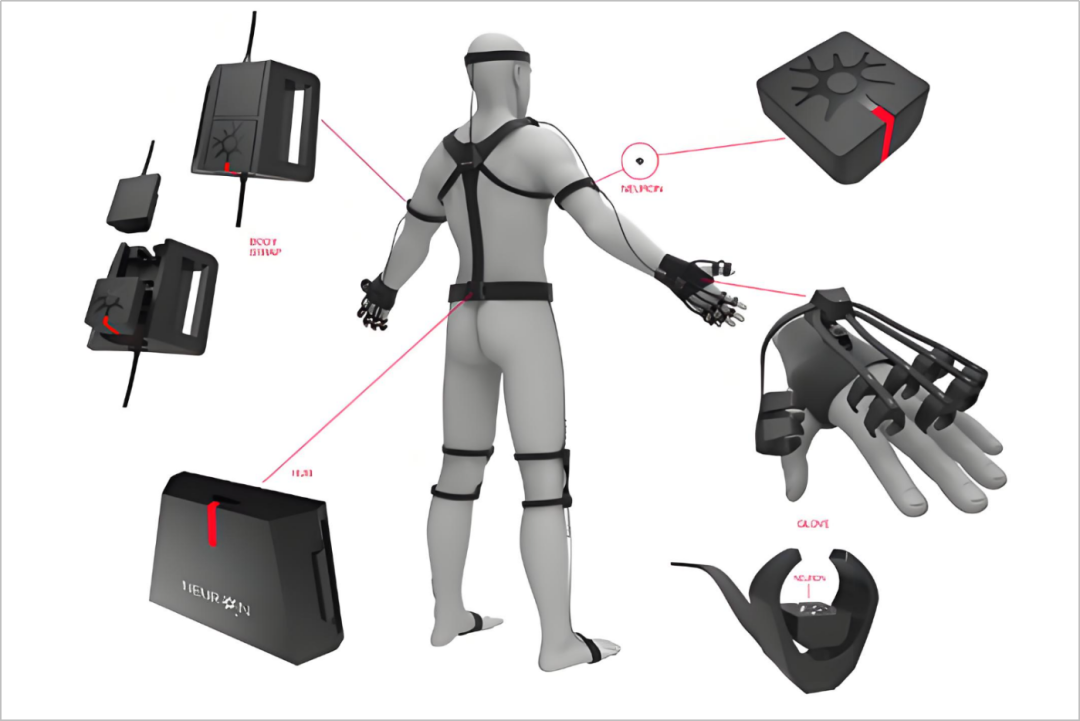

惯性传感器式动作捕捉系统

3. 三种常见的动作捕捉系统数据采集方式

1)基于真实机器人本体的数据采集方式

由真人穿戴动作捕捉设备,在真实环境中遥操作真实机器人本体,完成真实任务。在任务执行过程中,可以采集机器人本体真实的视觉信息、运控信息以及触觉信息等。该方式的优势在于采集到的数据质量非常高。缺点在于成本高昂,一个采集席位就需要一套机器人本体,一套动作捕捉设备,以及一个遥操作采集人员。

案例:特斯拉人形机器人 Optimus 的数据采集过程中使用了Xsens的惯性式动捕系统,并且是基于真实机器人本体的数据采集方式。据了解,特斯拉通过招募 “数据采集操作员”,通过穿戴动作捕捉设备模仿机器人所需动作来训练其人形机器人Optimus。

特斯拉要求其穿戴惯性动捕服和VR 头显,执行指定动作(如行走、搬运、上下楼梯等),并携带约 13.6 公斤的设备。这些动捕服集成了九轴惯性传感器(陀螺仪、加速度计、磁力计),能够实时捕捉人体关节的三维运动数据,包括角度、加速度和角速度。

2)基于虚拟机器人本体的数据采集方式

首先,在仿真环境(如 Gazebo、PyBullet、Unity 等)中构建与真实机器人本体构型一致的机器人数字模型,然后,由真人穿戴动捕设备,遥操作处于仿真环境中的虚拟机器人本体,模拟其运动及与虚拟环境的交互,来完成虚拟任务。在虚拟任务执行过程中,可以采集到虚拟机器人本体在仿真环境中的视觉信息、运控信息以及触觉信息等。

采集的数据虽然存在一些“域差距”(真实本体和虚拟本体之间的差距),但由于虚拟机器人与真实机器人本体构型是一致的,采集的数据质量相对较高。

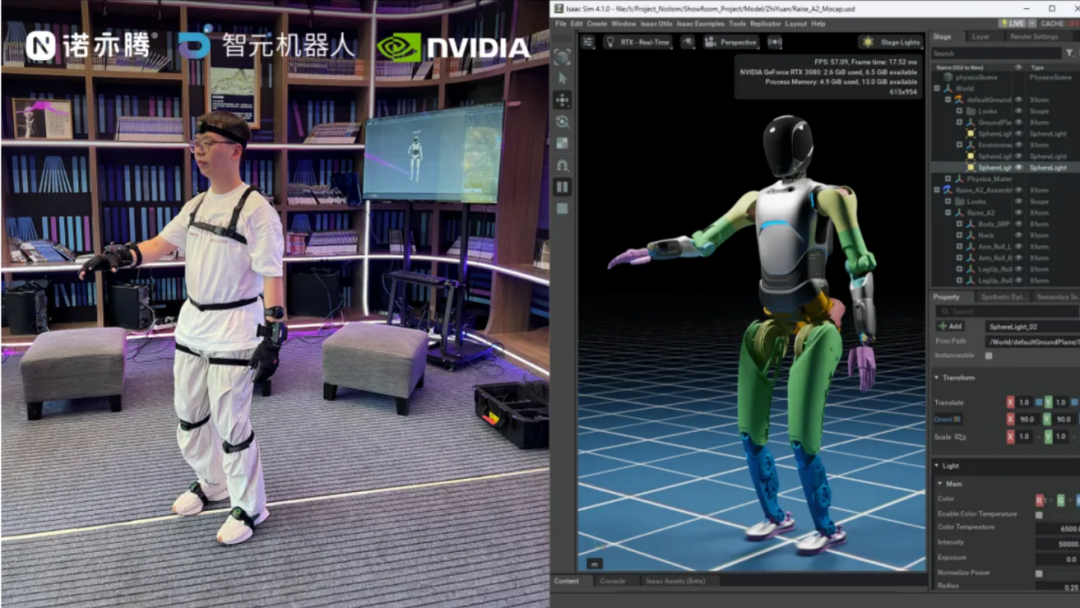

案例:智元机器人联合诺亦腾以及英伟达,采用虚拟机器人本体的数据采集方式。其中,英伟达提供了物理精确的虚拟环境与数据生成工具链,是规模化数据生产的核心引擎,比如Isaac Sim 仿真平台;诺亦腾作为动作捕捉技术供应商,为合作提供了高精度动作采集硬件与跨平台数据交互能力;智元机器人提供真实机器人远程A2本体,并在虚拟环境中构建数字孪生,是连接虚拟训练与实际应用的关键环节。

基于虚拟机器人本体的动作捕捉系统遥操作(图片来源:诺亦腾)

3)直接基于人体的数据采集方式

直接由真人穿戴动作捕捉设备去完成真实任务。在此过程中,借助光学、惯性等动捕设备,精准记录人体关节运动轨迹、姿态变化,为机器人模拟人类动作、实现人机协作提供基础数据支撑 。

目前,该采集方式尚处于科研阶段,存在比较大的跨本体鸿沟(Human2Robot Gap)。虽然人形机器人是仿人制造,但现阶段,人体与机器人在物理结构、运动机制、控制逻辑等方面还是存在比较大的差异,导致采集到的人体数据还难以直接映射到机器人的执行系统。

4. 国内典型动作捕捉解决方案企业介绍

1)诺亦腾(惯性和光学动捕)

北京诺亦腾科技有限公司成立于 2012年12月,致力于通过对人体以及物体运动的精准感知与智能分析,建立一致性模型,构造运动人体的“数字孪生”,构筑数字世界与物理世界的连接。

目前,诺亦腾的动捕技术与产品已经广泛应用在影视与游戏开发制作、文化与泛娱乐体验、医疗手术辅助及康复、运动测评与训练、工业仿真与虚拟教学等领域。

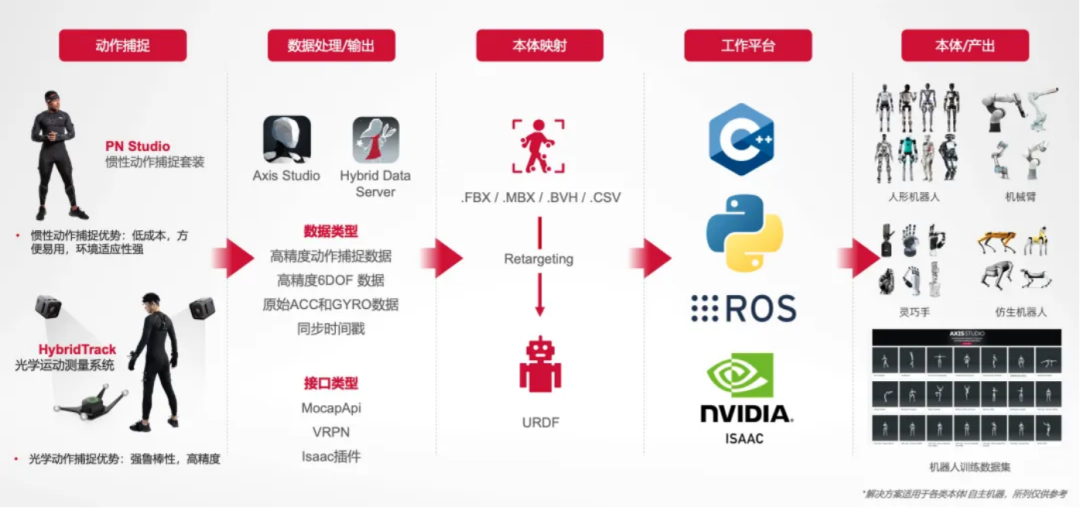

在具身智能机器人领域,诺亦腾可提供基于惯性传感器的 PN Studio 动作捕捉套装以及基于光学和惯性混合追踪技术的HybridTrack光学运动测量系统。其中,HybridTrack将惯性与光学系统的优质特性融合在一起,用光学定位补充惯性末端精度,用惯性传感器的数据源与光学计算进行紧耦合,提升光学系统的抗遮挡能力。

据了解,诺亦腾可提供覆盖具身智能机器人研发全流程阶段的完整解决方案,包括机器人遥操作、人机协同工作、机器人示教训练、高精度机器人状态量测量等能力。

诺亦腾具身智能机器人解决方案工作流程(图片来源:诺亦腾)

具身智能机器人领域应用案例:

借助 NVIDIA Isaac Sim & Isaac Lab 平台的系统架构以及数据生态,诺亦腾与机器人领域的多家企业、研究机构一起,打通动作捕捉系统与机器人虚拟本体/真实本体之间的工作回路,进而打造HITL (“Human - in - the - Loop”人在回路)解决方案。

基于自定义的 MocapApi 接口,诺亦腾实现了动作捕捉系统与 NVIDIA Isaac Sim 的数据联通,从而基于现有算法,快速接入动作捕捉和高精度追踪数据流,实时驱动仿真环境下的虚拟机器人本体或者真实的机器人本体,用遥操作的模式完成任务,采集数据。

目前,诺亦腾的动作捕捉系统已经为智元机器人、千寻智能等企业的遥操作控制和数据采集工作提供技术支持。

a. 智元机器人

2024年,诺亦腾携手智元机器人,基于 NVIDIA Isaac 以及动作捕捉/高精度追踪技术构建出 HITL 解决方案。智元远征A2 机器人可通过诺亦腾动作捕捉系统在真实物理世界与虚拟空间中进行遥操作采集数据集,用于训练策略/控制规则,共同探索提升算法的「Sim2Real2Sim」路径。

智元机器人远征A2动捕遥操作(图片来源:诺亦腾)

b.千寻智能

2024年,千寻智能与诺亦腾合作,采用诺亦腾PN3 Pro 惯性动作捕捉套装,进行动捕遥操作具身智能机器人。双方共同探索高效率、高精度的遥操作流程和数据产出流程,利用动作捕捉系统捕捉更多关节、更丰富的数据,为机器人训练积累数据。

千寻智能人形机器人动捕遥操作(图片来源:诺亦腾)

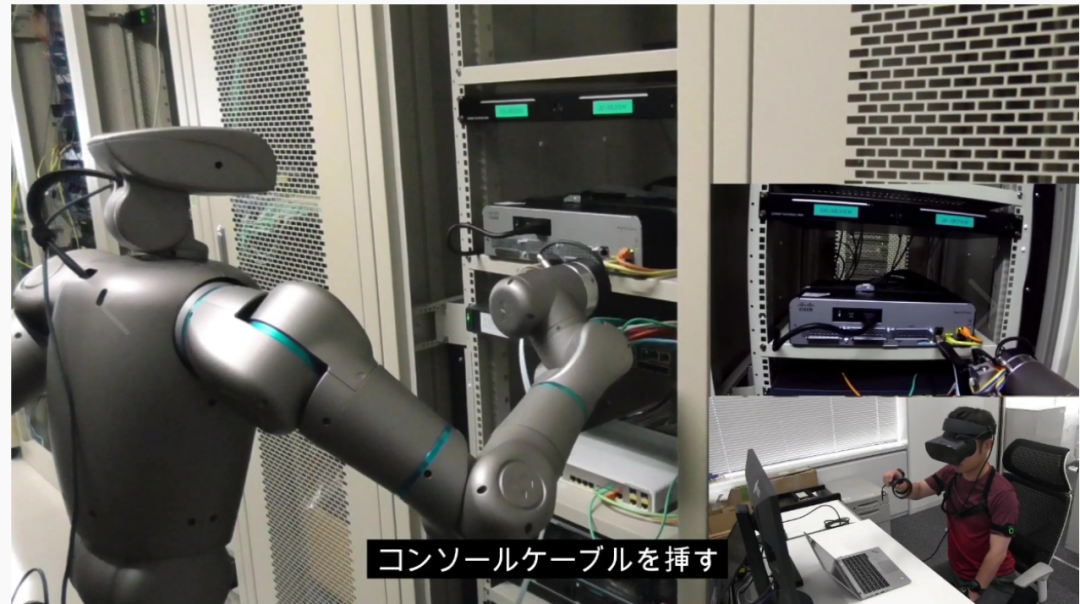

c. Tokyo Robotics

Tokyo Robotics是一家日本机器人公司,主营产品是机械臂和人形机器人。从2018年起,他们开展了利用动作捕捉系统操控机器人动作的研究。在2020年,公司成功将诺亦腾PN2.0和PN Studio惯性动作捕捉套装与其产品结合,用于帮助特殊领域工作人员进行安全的远程操作,同时积累训练数据,用于提升机器人性能。

Tokyo Robotics人形机器人动捕遥操作(图片来源:诺亦腾)

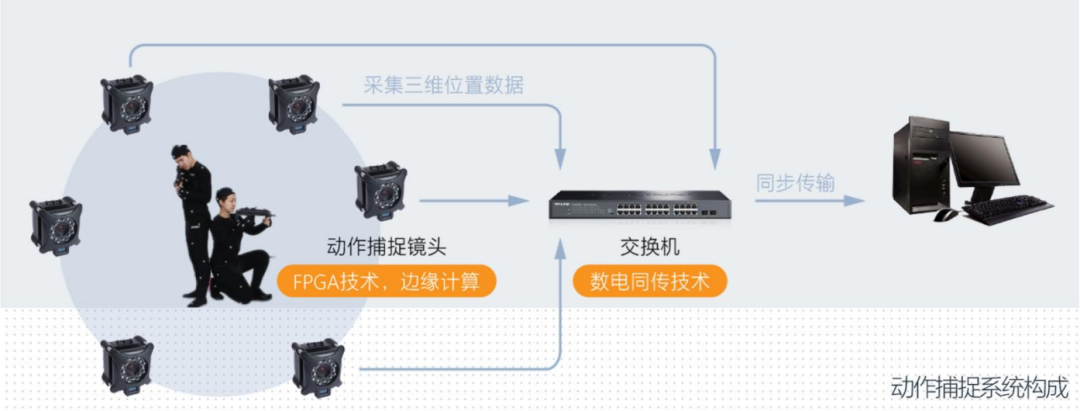

2)度量科技(被动式光学动捕)

北京度量科技有限公司成立于2015年8月。公司定位是专业光学动作捕捉设备提供商,致力于为客户提供完善的动作捕捉技术解决方案。

光学三维动作捕捉系统是度量科技的核心产品。该系统采用高性能红外摄像头捕捉被反光标记点(也被称为被动发光标记点)反射回的红外光,经过信号处理,获得反光标记点在镜头中的二维坐标。一套动捕系统里通常有多个动作捕捉镜头,多个镜头通过标定获取各镜头的位置、姿态参数(外参数)及光学参数(内参数),从而建立各镜头坐标系与世界坐标系的转换关系,最终解算出标记点的三维坐标。

光学动捕系统构成(图片来源:度量科技)

其中,光学动作捕捉镜头是动作捕捉系统的核心,镜头的分辨率与视场角等数据决定了整个动作捕捉系统的动作捕捉效果与精度。

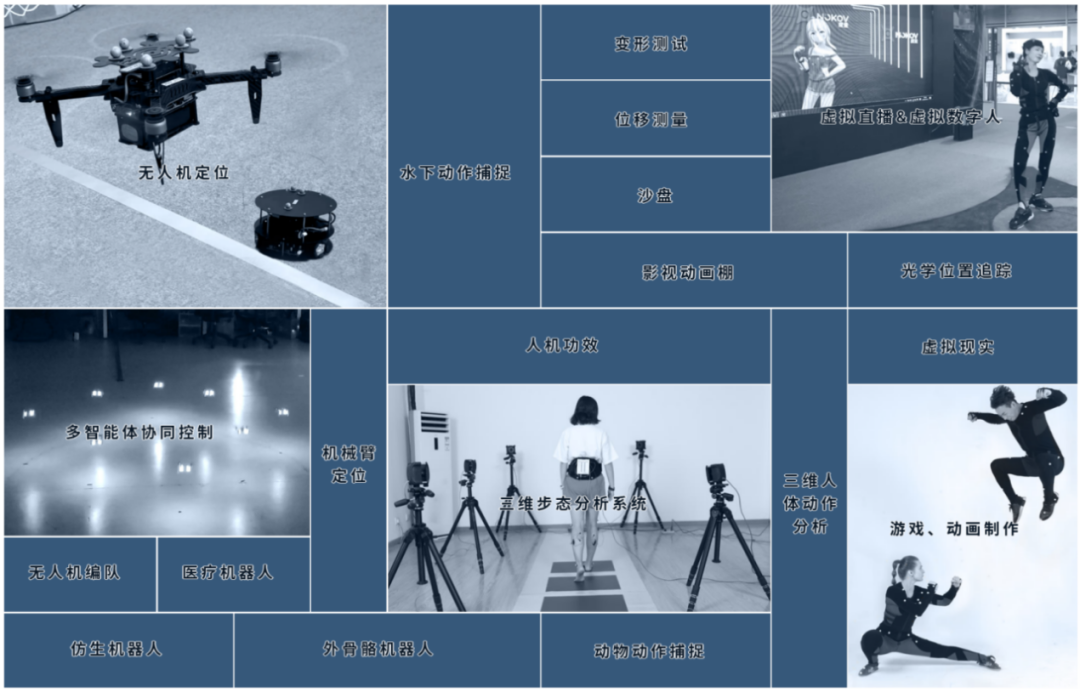

目前,该产品广泛应用在多智能体协同控制、无人机室内定位追踪、虚拟直播、电影动画、游戏制作等领域。

NOKOV(度量)光学三维动作捕捉系统主要应用领域(图片来源:度量科技)

具身智能机器人领域应用案例:

A. 哈尔滨工业大学 —— 3C 装配任务精确控制(示教学习案例):哈工大研究人员通过模仿学习方法,利用 NOKOV 度量光学动作捕捉系统捕获装配过程中人手的位姿信息,通过学习这些演示数据设计机器人控制策略,从而驱动机器人在新环境下完成相同的装配任务。

B. 南方科技大学 —— 精确步态分析:南方科技大学付成龙教授团队通过 NOKOV 度量动作捕捉系统与三维测力平台、表面肌电仪、足底压力测量仪等设备同步运行,获取人的六自由度的运动轨迹和运动学参数,进行精确的步态分析,为运动规划和位姿规划研究提供数据支持。

C. 北京航空航天大学 —— 下肢外骨骼上楼梯的自适应步态生成算法开发:北京航空航天大学陈伟海老师研究团队通过 NOKOV 度量动作捕捉系统,收集一系列健康人在平地和楼梯上行走的下肢运动数据,形成完整的下肢关节模型。研究中,将动作捕捉系统获取的髋关节角度和膝关节角度表示为下肢行走步态。

D. 浙江工业大学 —— 机器人灵巧手研究:浙江工业大学机械学院研究团队在多关节多自由度的机器人灵巧手方面深入研究,通过 NOKOV 度量光学动捕系统采集受试者手部关节位置信息,计算各关节间角度变化、角速度变化、指尖运动轨迹及相关系数,依据这些数据进行灵巧手的原型开发。

3)元客视界(光学动捕)

北京元客视界科技有限公司成立于2022年11月,是机器视觉头部企业凌云光设立的全资子公司。元客视界专注于运动捕捉、光场重建、虚拟拍摄系统以及智能资产制作等产品和解决方案。

FZMotion是元客视界自研的光学运动捕捉系统,该系统主要由 Swift 系列红外光学运动捕捉相机和智能分析软件(“Moca运动跟踪分析软件”和“Motar运动捕捉分析软件”)构成,能够重建特征点三维运动轨迹,解算物体空间位姿或人体动作等运动信息,从而实现运动物体的高精度运动捕捉。

其中 Swift 系列相机具有多种型号,能够满足大视野、高速、高精度场景的拍摄需求,帧速率最高可达 500FPS,曝光时间低至1us,追踪范围可达 10m~30m。系统支持多种数据传输协议和软件接口,具备强大的抗遮挡能力和数据自动修复功能。

FZMotion 光学运动捕捉系统可广泛应用在影视动画、游戏、虚拟现实、医疗、教育、无人机、工业仿真、康复训练、舞台演艺、运动科学分析等领域。

具身智能机器人领域应用案例:

据相关媒体透露,在具身智能机器人领域,元客视界已经服务宇树科技、优必选、小米等客户。

a.宇树科技

2024年11月,在青岛举办的中国自动化大会上,元客视界与宇树科技联合展出了 FZMotion 具身智能数据采集解决方案,向业界展示了该方案在推动自动化、具身智能发展方面的前沿技术和创新应用。

通过FZMotion 光学运动捕捉系统,元客视界可将人体骨骼数据直接映射到宇树 H1 机器人构型并驱动本体,高精度采集机器人本体的姿态和运动轨迹真值,以此优化任务策略和控制算法,助力人形机器人更好地适应复杂环境和任务。该系统能以亚毫米级精度捕捉人体和机器人的运动数据,减少二次开发成本,显著缩短产品迭代周期。

b.睿尔曼智能

2025年4月,依托 FZMotion 光学运动捕捉系统,元客视界联合睿尔曼智能打造的数据采集解决方案入驻北京首个人形机器人数据训练中心。

整体解决方案通过多个动捕相机精确定位人体的每个关节运动轨迹,驱动机器人模仿动作。据了解,该解决方案的捕捉精度达到亚毫米级(0.1mm 绝对位置精度),且通过多传感器、多模态稳健捕捉技术,弥补了传统光学采集中抗遮挡不易被采集的劣势。

另外,一套光学数据采集系统可以同时覆盖多个工位,且多工位间操作采集相互独立、互不干扰;这意味着,在不增加硬件成本的前提下,该系统能够同步获取丰富多元的信息,其中包括人体骨骼运动数据、机器人电机运行参数,以及视觉控制数据、点云数据等。

4)虚拟动点(光学动捕)

虚拟动点于 1996 年成立于美国,专注于运用视觉与图像技术解决运动追踪问题,是全球较大的光学运动捕捉技术供应商。2017年,利亚德集团美国平达公司以 1.25 亿美元收购了虚拟动点公司,使其成为全资子公司。2017年3月,北京虚拟动点科技有限公司在北京注册成立。

目前,虚拟动点的动作捕捉产品有光学动作捕捉OptiTrack系列和无标记点动作捕捉LydCap系列。产品广泛应用于影视动漫、医疗、工业制造、教育、体育等领域。

OptiTrack的Motive软件是其动作捕捉系统的核心。Motive3.1软件具有可被训练的标记点集、新增使用IMU传感器融合平滑刚体跟踪功能、新增相机复位功能、刚体骨骼追踪等亮点功能;Motive:Tracker是OptiTrack开发的专业面向物体六自由度跟踪的、支持实时数据处理和离线数据处理的高精度运动跟踪软件。

另外,虚拟动点OptiTrack系列还提供多种类型的动作捕捉相机,包括Prime 系列、Slim 系列、Flex系列等,以满足不同应用场景的需求。

具身智能机器人领域应用案例:

2024年12月,虚拟动点与松延动力合作成立了“具身智能机器人联合实验室”。

表情捕捉与交互:虚拟动点与松延动力联合研发,将面部捕捉技术赋能仿生机器人,使松延动力的仿生机器人学会了 “喜怒哀乐” 等拟人化表情,并且可以读懂人类的语言并做出表情回应,提升了机器人的拟人化程度和交互能力。

复杂动作训练:2025年3月,虚拟动点赋能松延动力的机器人解锁连续空翻技能。虚拟动点可以为机器人合作伙伴提供高质量的优质动作数据,通过数据开发与动作训练,帮助机器人学会更复杂、更高难度的动作。

5)青瞳视觉(光学式动捕)

上海青瞳视觉科技有限公司成立于2015年8月,专注于3D智能感知和人机交互系统的研发和生产。据了解,青瞳视觉自主研发的红外光学动作捕捉系统能够达到亚毫米级(±0.02mm)的捕捉精度、毫秒级(2.5ms)的延时性能。该产品广泛应用于元宇宙、数字娱乐、虚拟现实、科研与工业自动化和生命工程等领域。

在具身智能领域,青瞳视觉可为具身智能研究提供机器人训练研究解决方案,包含运动能力评测、性能对比分析、多场景适应性测试、空间感知能力评测、高保真环境模拟等,提供多维度、高质量训练数据集,助力人形机器人技术提升和产业升级。

另外,青瞳视觉的光学手指追踪技术,能够精准实现精细的手部动作捕捉,在灵巧手研究、机械臂定位测量等场景中展现出较强应用价值。目前,青瞳视觉与荣耀、清华大学、浙江大学、苏州大学等达成合作,通过提供先进的光学手指追踪技术支持,助力合作伙伴在灵巧手方面的研究与开发。

具身智能机器人领域应用案例:

2024年,人形机器人(上海)有限公司(国地共建人形机器人创新中心)采用青瞳视觉光学动捕系统,进行全尺寸机器人“青龙”的训练,通过采集“青龙”的数据信息,进行姿态分析、运动评估等工作。