阅读时间大约10分钟以上(4025字)

阅读时间大约10分钟以上(4025字)

2025-09-09 灵巧手:不止是小脑,更是大脑

出品:人形研习社

一台搭载最新灵巧手的机器人:

面对滚落的鸡蛋,没有像传统机械臂那样生硬撞击,而是先通过视觉判断鸡蛋轨迹,再用三根手指以120°均匀受力的方式轻轻托住,触觉传感器实时感知蛋壳反馈的微小形变,最终稳稳将鸡蛋放入托盘。

这个看似简单的动作,十年前在实验室里还是难以实现的“技术难题”,如今却成了新一代灵巧手的“基础操作”。

很多人误以为,灵巧手的核心是“手”的精密:比如能模仿人类手指的关节活动,却忽略了真正让它突破瓶颈的,是“脑”与“手”的协同:

“小脑”(运动控制系统)负责毫米级的精准控制,“大脑”(决策认知系统)则负责理解环境、判断物体属性、规划操作策略。

今天,我们从技术底层扒一扒,看看灵巧手如何像人类一样“心灵手巧”。

从“抓得住”到“抓得好”:灵巧手如何工作的

在解释“脑”与“手”的分工前,我们先得明白一个核心逻辑:

人类之所以能灵活操作物体,靠的是“感知-决策-执行”的闭环神经回路:

眼睛看到杯子(感知),大脑判断“这是玻璃材质,要轻握”(决策),手和手臂配合完成抓取(执行),同时触觉反馈让大脑调整力度(闭环)。

灵巧手的设计,正是对这套人类神经回路的“机器复刻”,但每一步都需要技术突破。

1.三层架构:撑起灵巧手的“感知-决策-执行”闭环

感知层:给灵巧手装上“眼睛”和“皮肤”

感知层是“信息入口”,相当于人类的视觉和触觉。

视觉上,我们会用高精度3D相机(比如工业级的梅卡曼德 ),它能捕捉到0.02mm精度的物体三维点云:这意味着哪怕是螺丝表面的细微纹路,都能被清晰识别。

触觉上,灵巧手的手指关节和掌心会贴附“柔性触觉传感器”(如帕西尼感知的TSR系列),它能分辨20种不同表面纹理(从光滑的金属到粗糙的木材),还能感知0.01N的微小力变化:相当于一根头发丝落在手上的力度。

举个例子:当灵巧手要抓取一块蛋糕时,视觉传感器先判断蛋糕的大小、形状和奶油分布,触觉传感器则会提前“感知”蛋糕的柔软度,为后续决策提供数据基础。

决策层:灵巧手的“大脑”,负责“想明白再做”

决策层是灵巧手的核心,相当于人类的大脑皮层。

它的核心任务是:基于感知层的数据,判断“这是什么物体”“该用什么方式抓”“抓的时候要注意什么”。

早期的灵巧手决策靠“预设程序”:比如只能抓固定大小的杯子,换个盘子就会失败。

而现在的决策层,靠的是“多模态大模型”(如星动纪元的ERA-42、阿里巴巴的“通义千问”工业版):

它能融合视觉(物体外观)、触觉(物体硬度)、物理规则(比如玻璃怕摔、鸡蛋怕压)等多维度信息,快速生成最优策略。

还是以抓鸡蛋为例:决策层先通过视觉识别“这是鸡蛋”,再调用内置的“物体属性库”,知道鸡蛋的抗压强度小于5N(超过就会碎),然后规划出“三指协同、120°均匀受力”的抓取方案,甚至会提前预判“鸡蛋可能会滑动”,预留0.1N的防滑冗余力。

执行层:灵巧手的“小脑”,负责“精准落地”

执行层相当于人类的小脑,负责将决策层的“想法”转化为精准的动作。

它的核心是“运动控制器”(如固高科技的GTC-800),能以1000Hz的频率(也就是每秒1000次)调整手指关节的力度和角度:这个响应速度比人类快5倍以上,能实时补偿操作中的微小误差。

比如抓鸡蛋时,若手指接触点有0.1mm的偏移,执行层会在0.001秒内调整关节角度,确保受力均匀;如果触觉传感器检测到蛋壳有微小裂纹(反馈力出现异常波动),执行层会立刻切换为“双手托持模式”,避免鸡蛋破碎。

2.神经科学的启发:从“人类协同”到“机器协同”

很多人问:“为什么灵巧手的‘脑-手’协同能这么高效?”

答案藏在人类自身的神经系统里。

人类大脑运动皮层(负责决策)和小脑(负责控制)每秒会进行500次信息交换,这种高频协同让我们能完成“用筷子夹花生”“穿针引线”等精细动作。

灵巧手的研发正是借鉴了这一机制。比如伯牙智能的D22 Pro灵巧手,通过专用通信协议将“大脑”(决策系统)和“小脑”(控制系统)的通信延迟压缩到了2ms以内:

这意味着两者每秒能交换500次数据,和人类的神经协同速度相当。正是这种“类人协同”,让灵巧手摆脱了“机械僵硬”的标签,开始具备“灵活应变”的能力。

灵巧手的“大脑”:不是“会计算”,而是“会思考”

在灵巧手的研发中,“大脑”(决策认知系统)的突破是最难的,也是最关键的。

早期的灵巧手之所以“笨”,就是因为“大脑”只能做简单的“指令执行”,而现在的“大脑”,已经能像人类一样“理解环境、推理物理规则、规划复杂任务”:

这才是灵巧手能完成精细操作的核心原因。

1.多模态理解:让“大脑”看懂、摸懂物体

“大脑”要做决策,首先得“看懂”和“摸懂”物体。

这就需要“多模态融合技术”:把视觉、触觉、甚至听觉(比如抓取时物体的碰撞声)的数据整合起来,形成对物体的完整认知。

比如在3C电子工厂里,灵巧手要抓取一个iPhone的排线(厚度只有0.3mm,材质脆弱):

视觉模态:通过高分辨率相机识别排线的位置、角度,甚至能看到排线表面的细微划痕(判断是否完好);

触觉模态:通过手指上的微型力传感器,感知排线的柔软度(力度超过0.1N就会折断),以及排线与插槽的接触反馈(是否插到位);

物理推理:“大脑”会根据排线的材质特性,推理出“插入时要保持水平,不能倾斜”,还要考虑“插槽可能有轻微偏移,需要微调角度”。

正是这种多模态理解,让“大脑”能应对复杂场景。比如当视觉被遮挡(比如排线被其他零件挡住70%),“大脑”可以靠触觉反馈继续完成插入动作:这就像人类闭着眼睛也能系鞋带,靠的是触觉记忆和推理。

2.决策架构的进化:从“死记硬背”到“灵活应变”

举个例子:在特斯拉上海工厂的汽车装配线中,早期用的是“集中式架构”的灵巧手,只能锁附固定型号的螺丝;

后来换成“分层式架构”后,“大脑”能先识别螺丝型号(M5还是M6),再调用对应的锁附策略(扭矩5±0.2N・m),还能和工人协作:当工人递来不同螺丝时,“大脑”能实时调整操作,不用重新编程。

而在更复杂的场景,比如家庭服务机器人,“端到端架构”的优势就体现出来了:

当它要抓取一个从未见过的“异形水杯”时,“大脑”不用预设程序,而是通过大模型分析水杯的形状(视觉)、重量(触觉),直接生成“用掌心托底+两指辅助固定”的策略:

这就是“灵活应变”的能力。

3.认知瓶颈的突破:让“大脑”会“规划”“应对意外”

“大脑”的高级能力,体现在对“复杂任务”和“意外情况”的处理上。

长序列规划:完成“多步骤任务”

早期的灵巧手只能做“单步操作”(比如抓杯子),现在的“大脑”能规划“多步任务”。

比如装配乐高积木:“大脑”会先分析积木的拼接顺序(先拼底座,再拼侧面),再规划每一步的抓取、对准、拼接动作,甚至会考虑“先抓小积木,再抓大积木,避免遮挡”:这就像人类搭积木时的“先难后易”思路。

不确定性处理:应对“意外情况”

现实场景中总有意外:比如抓取时物体突然滑动,或者视觉被遮挡。

现在的“大脑”能通过“概率推理模型”应对这些情况。比如当灵巧手抓一个光滑的金属零件时,“大脑”会预判“有30%的概率滑动”,提前让手指施加0.05N的防滑力;

如果真的发生滑动,触觉传感器会立刻反馈,“大脑”在0.01秒内调整手指位置,避免零件掉落。

跨领域迁移:把“经验”用到新场景

人类能把“用筷子夹菜”的经验,迁移到“用镊子夹零件”上,灵巧手的“大脑”也能做到。

比如我们在医疗手术场景中训练的“精细操作模型”(如缝合伤口时的力度控制),可以迁移到3C电子场景的“排线插接”上:因为两者的核心都是“微小力控制”和“精准定位”。

这种“知识迁移”,让灵巧手不用在每个场景重新训练,大大降低了应用成本。

灵巧手的“小脑”:不是“会动”,而是“动得准”

如果说“大脑”负责“想明白”,那“小脑”(运动控制系统)就负责“做得到”。

很多人以为“动得快”就是好,但对灵巧手来说,“动得准”“动得稳”“动得柔”才是关键:

比如抓鸡蛋时,力度差0.1N就会碎;插排线时,角度偏0.1°就插不进去。这部分的技术突破,是灵巧手能完成精细操作的“硬件基础”。

1.运动控制技术的四代迭代:从“僵硬”到“仿生”

灵巧手的“小脑”技术,十年里经历了四代迭代,每一代都在“精度”和“柔性”上实现突破:

第一代:预设轨迹控制(2010-2015年)

这是最早期的技术,核心是“按预设程序动”:比如手指的运动轨迹是提前编好的,力度也是固定的。缺点很明显:精度差(误差>1mm),没有柔性,只能抓“形状规则、硬度高”的物体(如金属块),抓鸡蛋、蛋糕这类柔性物体一定会坏。

第二代:力位混合控制(2015-2018年)

加入了“力反馈”:手指能感知接触力,然后调整力度。比如抓杯子时,力度达到预设值就会停止,不会捏碎杯子。精度提升到0.2mm,但还是不够灵活,比如抓异形物体时,容易出现受力不均。

第三代:仿生反射控制(2018-2024年)

借鉴了人类的“反射神经”:比如手碰到热水会立刻缩回。这种技术让“小脑”能实时响应触觉反馈:比如抓物体时,只要触觉传感器检测到“滑动”,“小脑”会在0.001秒内调整力度,不用等“大脑”指令。精度提升到0.05mm,能完成“抓鸡蛋”“插排线”等精细操作(比如伯牙智能的D22 Pro就用了这种技术)。

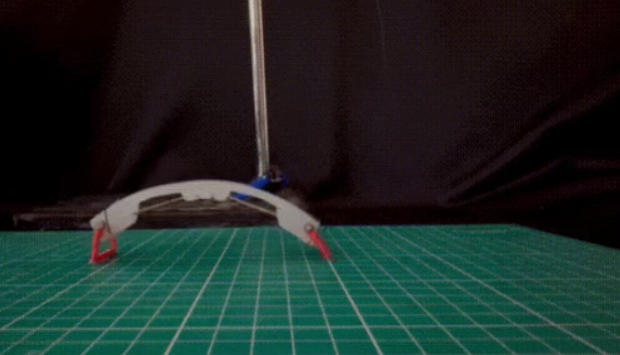

第四代:预测性自适应控制(2024年至今,实验室阶段)

这是最新的技术,核心是“预判”:“小脑”会根据物体的运动趋势,提前调整动作。比如抓取滚动的乒乓球时,“小脑”会根据乒乓球的轨迹,预判接触点,提前调整手指位置,而不是等接触后再反应。目前实验室里的精度已经能达到0.01mm,未来会逐步落地。

2.核心性能指标:看“小脑”好不好,就看这几个数

判断“小脑”的性能,不用看复杂的参数,只要看三个核心指标:自由度、力控分辨率、动态响应频率。

自由度(DOF):相当于手指的“关节数量”,越多越灵活。人类手指有27个自由度,灵巧手目前最高24个,能模仿人类90%以上的手指动作。

力控分辨率:能感知的最小力变化,越小越“柔”。0.01N的分辨率,意味着能感知到“一根头发丝的重量”,抓鸡蛋时不会用力过猛。

动态响应频率:每秒调整动作的次数,越高越“稳”。3kHz的频率,意味着每秒能调整3000次动作,即使物体有微小滑动,也能立刻修正。

异常恢复时间:出现异常(如力度过大)后,恢复正常的时间,越短越安全。50ms的恢复时间,能在鸡蛋刚出现裂纹时就停止用力,避免破碎。

3.前沿探索:让“小脑”更像人类的“手”

现在的“小脑”已经很精准了,但我们还在追求“更仿生”:让灵巧手的“手”不仅能“动得准”,还能“有感知”“省能量”。目前有三个前沿方向:

肌肉仿生驱动:像人类肌肉一样“发力”

传统灵巧手用的是“电机+减速器”,虽然精准,但体积大、重量重。哈佛大学最近研发了“介电弹性体驱动”:用柔软的材料模拟人类肌肉,通电后能收缩发力,重量只有传统电机的1/5,还能实现“柔性弯曲”(比如手指能像人类一样自然弯曲)。

未来这种技术能让灵巧手更轻便,适合穿戴式场景(如康复机器人)。

本体感知融合:让“手”知道自己的位置

人类的手即使不看,也知道自己的位置(比如闭着眼睛能摸到鼻子),靠的是“本体感知”。

灵巧手现在也在加这种能力:在关节里装“力矩传感器”和“位置传感器”,让“小脑”实时知道每个手指的位置和角度,不用依赖视觉。比如苏黎世理工的灵巧手,即使视觉被完全遮挡,也能靠本体感知完成“拧螺丝”的动作。

能量优化:让“手”更“省电”

传统灵巧手抓物体时,电机要一直发力,很费电(比如持续抓1小时就要充电)。

东京大学最近提出了“被动抓取”方案:在手指关节里加“弹性元件”,像人类抓东西时靠肌肉张力保持姿势一样,灵巧手能靠弹性元件“卡住”物体,不用电机一直发力,持续抓握能耗降低60%:

这对移动机器人(如家庭服务机器人)很重要,能大幅延长续航。

“脑-手”协同:不是“各做各的”,而是“一起配合”

很多人以为,只要“大脑”够聪明、“小脑”够精准,灵巧手就能做好精细操作:但实际不是。

“脑-手”协同的难点,在于“两者如何高效配合”:比如“大脑”的决策要及时传给“小脑”,“小脑”的反馈要快速。

2025-2027年,我们将见证灵巧手在工业场景的渗透率从不足5%跃升至30%;到2030年,具备自主学习和实时决策能力的“脑-手”协同系统将成为智能工厂的标准配置。

这条进化之路不仅需要算法突破和硬件创新,更需要打破学科壁垒的深度融合思维。