阅读时间大约8分钟(2803字)

阅读时间大约8分钟(2803字)

2025-11-21 DeepMind最新框架PhysWorld来了 让机器人看一段生成视频就能学会复杂操作?!

作者:李鑫 出品:具身智能大讲堂

当我们期待机器人自主完成擦白板、浇花、倒菜等日常任务时,一个核心难题始终存在:如何让机器人高效学习这些技能,同时避免高昂的真实数据采集成本?

近日谷歌DeepMind联合南加州大学、斯坦福大学等机构提出的PhysWorld框架,通过视频生成与物理世界建模的深度融合,让机器人仅靠单张图像和文字指令,就能"看懂"生成的演示视频,进而学会零样本的真实世界操作,无需任何真实机器人演示数据。

1►生成视频存在致命缺陷 物理鸿沟难跨越

近年来,视频生成模型发展迅猛,能够根据图像和文字指令合成逼真的任务演示视频。比如"把番茄从平底锅倒进白盘子"的全过程。这些生成视频本应是机器人学习的宝贵素材,却存在一个致命缺陷:视频生成模型只会追求视觉上的合理,却忽略了物理世界的基本规律。

直接将生成视频中的像素运动转化为机器人动作,往往会出现"看起来可行,做起来离谱"的情况,比如机器人倾倒动作力度失控,或抓取姿势违反力学平衡。此前的解决方案要么需要大规模真实机器人数据校准,成本极高;要么直接提取视频中的视觉线索(如光流、物体轨迹)驱动机器人,却因缺乏物理约束导致操作精度低下。

DeepMind团队指出:连接生成视频与机器人动作的核心瓶颈,是物理可行性。视频生成负责"看起来像",而机器人操作需要"做得对",这两者之间的鸿沟,必须用物理世界建模来填补。

2►PhysWorld核心思路:给生成视频"搭个物理舞台"

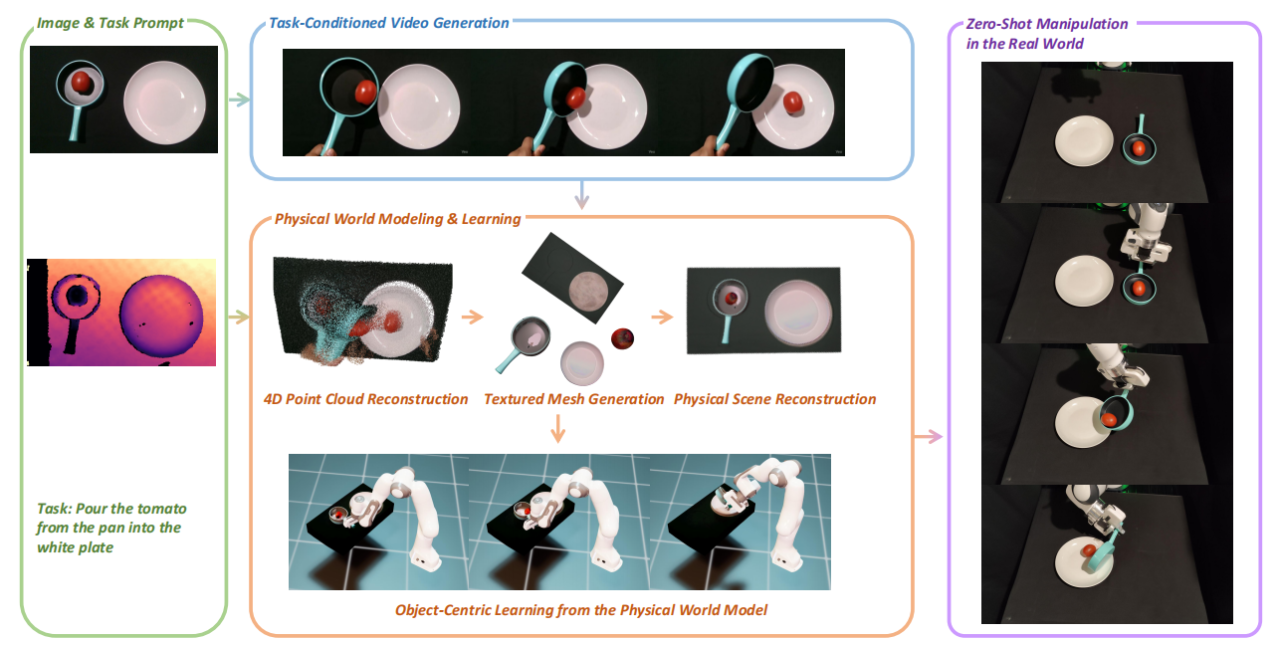

PhysWorld的本质,是为生成的虚拟演示视频,重建一个可交互的物理世界模型,让机器人在这个"数字孪生舞台"上学习,再将学到的技能迁移到真实世界。其完整流程可拆解为三大关键步骤。

第一步:生成任务专属演示视频

输入一张真实场景的RGB-D图像(既有彩色信息也有深度信息)和文字任务指令(如"把书放进书架"),PhysWorld会调用视频生成模型(主要使用Veo3),合成一段展示任务完成过程的视频。这段视频不是随意生成的,而是严格匹配输入图像的场景布局,确保视觉演示与真实环境的一致性。

值得注意的是,视频生成质量直接影响后续操作效果。实验显示,Veo3生成的视频中有70%能稳定提取物体运动信息,而其他通用视频生成模型的可用率最高仅36%,最低仅2%。这也说明,高质量、任务一致性强的视频生成,是整个框架的基础。

第二步:从视频中重建物理世界

这是PhysWorld的核心创新——把2D视频转化为3D可交互的物理场景,相当于为机器人搭建一个"模拟训练场"。具体分为四个细节操作:

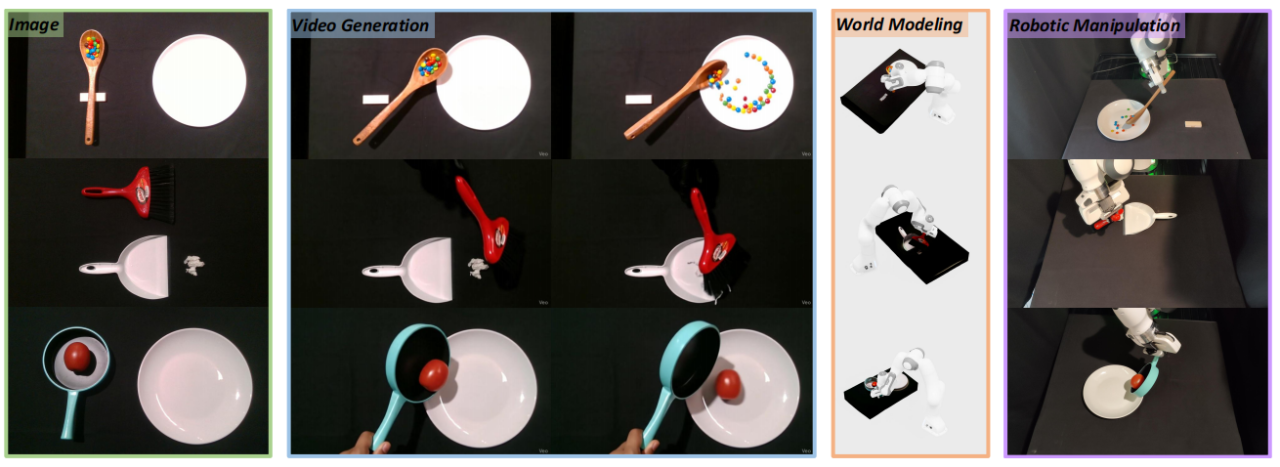

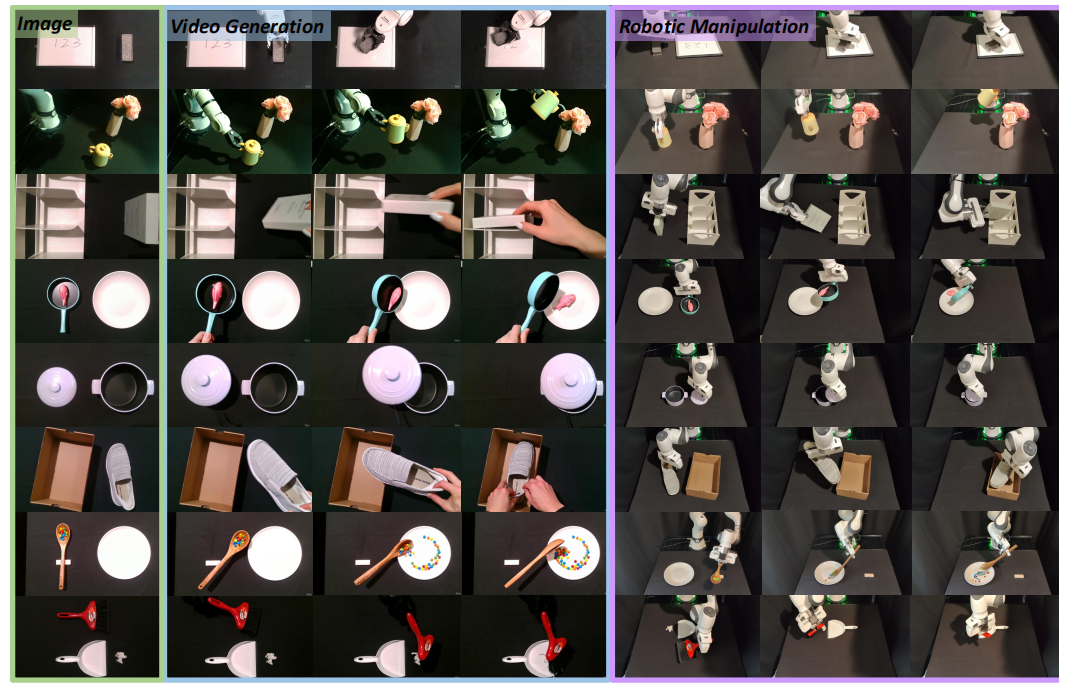

PhysWorld:一个基于视频生成的机器人学习框架。该方法以一张图像和一条任务提示作为输入(第1列),先生成一段任务条件下的演示视频(第2列),再通过重建底层物理世界,将生成的视觉演示转化为物理上可行的机器人动作(第3列),最终实现真实世界中的零样本机器人操作(第4列)。

4D时空重建:先通过MegaSaM模型提取视频每一帧的深度信息,再用真实图像的深度数据校准,得到符合真实尺度的动态点云,还原场景的空间结构和运动轨迹;

纹理网格生成:将场景拆分为物体和背景,用图像修复技术补全被物体遮挡的背景区域,再通过图像转3D模型生成物体和背景的完整纹理网格(模拟器通用的几何表示);

物理属性赋值:借助视觉语言模型(VLM)的常识知识,为每个物体和背景分配物理参数——比如盘子的质量、桌面的摩擦系数,让虚拟场景符合真实物理规律;

场景校准优化:调整场景的重力方向(确保与真实世界一致),优化物体摆放位置避免初始碰撞,最终形成一个"拿过来就能用"的物理模拟环境。

这个过程最巧妙的地方在于,仅靠单目生成视频就能完成3D物理场景重建,无需多视角拍摄,解决了传统方法对采集设备的依赖。

第三步:物体中心的残差强化学习

有了物理场景,机器人如何高效学习?PhysWorld放弃了传统的"模仿人体/机器人姿态"的思路,转而聚焦物体运动——因为生成视频中可能出现虚假的人手/机器人模型,但物体的运动轨迹更稳定、更易提取,也更直接反映任务目标。

PhysWorld流程:输入一张RGB-D图像(兼具彩色与深度信息的图像)和一条任务提示后,我们的框架将按以下步骤运行:(1)生成一段任务条件约束下的演示视频;(2)基于生成的视频,重建几何对齐的4D(三维空间+时间)表征;(3)生成带纹理的物体及背景网格模型;(4)通过物理属性估计、重力方向校准及碰撞优化,将上述网格组装为可物理交互的场景;(5)学习以物体为中心的残差强化学习策略,将视觉演示转化为可行的机器人动作;(6)部署至真实物理世界。

3►具体采用"残差强化学习"策略,兼顾效率和鲁棒性:

基线动作打底:先用现成的抓取模型和运动规划器,生成完成任务的基础动作轨迹(比如"伸手-抓取-移动-放置"的大致路线);

残留政策修正:在物理模拟器中,通过强化学习训练一个"修正模型",针对基线动作的偏差进行微调。比如基线动作可能导致抓取位置偏移,修正模型会根据物理反馈(如物体是否滑落)调整手爪位置和角度;

奖励机制引导:设计简单且通用的奖励函数,既鼓励机器人精准跟踪视频中的物体运动轨迹(位置误差越小奖励越高),也惩罚抓取失败、动作不可行等情况,确保学习方向不偏离任务目标。

这种"基线+修正"的学习方式,比从零开始训练强化学习模型效率高得多——仅需几百次迭代就能收敛,且在复杂任务中表现更稳定。

4►实测效果:零样本操作准确率碾压传统方法

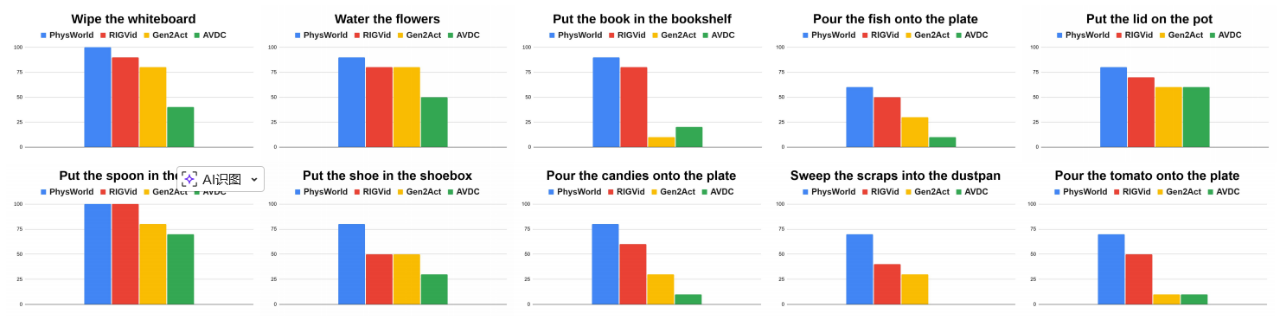

为了验证PhysWorld的性能,研究团队在10个真实世界机器人操作任务上进行测试,包括擦拭、倾倒、放置、清扫等多样化场景,每个任务重复10次,核心结果如下:

PhysWorld在真实世界操作任务中的定量评估

PhysWorld在真实世界操作任务中的定性评估

准确率大幅领先

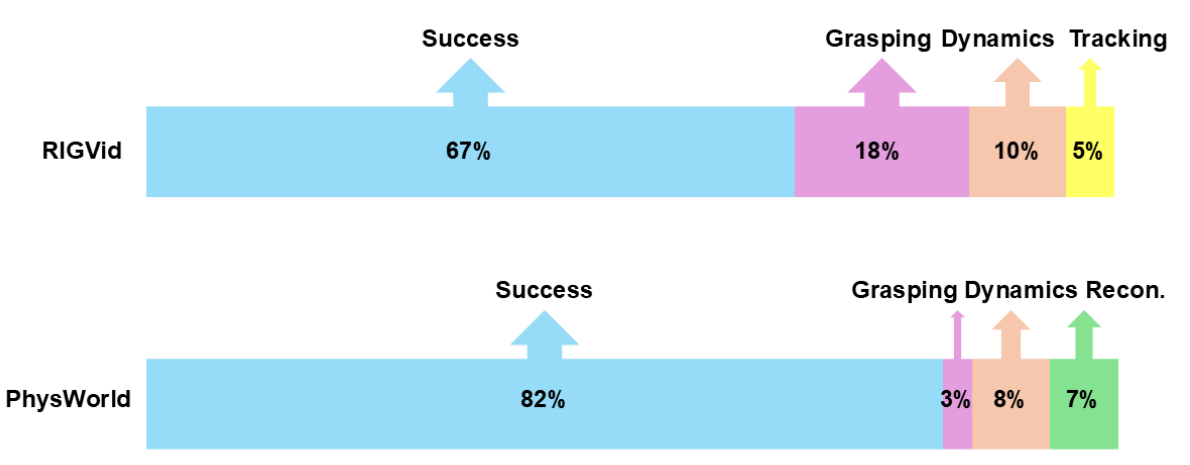

失效模式分析

PhysWorld的平均任务成功率达到82%,远超其他零样本方法:直接跟踪物体姿态的RIGVid(67%)、提取稀疏点轨迹的Gen2Act、基于光流的AVDC。

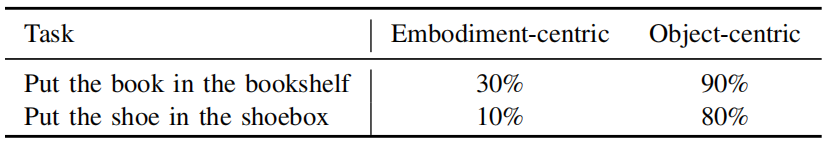

以物体为中心的学习 vs 以具象为中心的学习

其中在"把书放进书架"任务中,成功率高达90%,而传统姿态模仿方法仅30%。

失败率明显降低

通过失败模式分析发现,引入物理世界模型后,抓取失败率从18%骤降至3%,跟踪失败率从5%降至0%——这正是物理反馈的价值:机器人在模拟环境中能提前"感知"到抓取不稳、轨迹偏差等问题,及时修正,避免真实世界中的操作失误。

泛化能力突出

无需针对特定任务调整模型,也无需任何真实机器人数据,就能直接应用于10种不同任务。这打破了传统机器人学习"一个任务一套数据"的局限,真正实现了零样本泛化。

5►为什么这样设计能成功?

PhysWorld的设计之所以能取得突破,本质上是因为其精准抓住了三个核心矛盾的解决方案,这也是它相比传统方法的优势所在:它通过物理建模填补“视觉-动作”鸿沟,不直接将像素运动映射为机器人动作,而是借助物理世界模型将视觉演示转化为可验证的物理轨迹,确保动作符合力学规律。

同时聚焦物体运动而非姿态模仿,避开生成视频中可能存在的虚假姿态信息,紧扣“任务的核心是改变物体状态”这一本质,让学习目标更明确、更稳定;此外,残留学习机制有效平衡了效率与鲁棒性,借助基线动作缩小探索空间,再用强化学习修正偏差,既避免了从零学习的低效,又解决了纯规划方法的僵硬问题。

当然,PhysWorld也存在局限性:物理模拟的保真度会影响真实世界的操作效果,单目视频重建可能在遮挡区域出现几何偏差,但研究团队指出,通过提前对环境进行多视角重建,可进一步降低这种偏差。

6►结语与未来:

PhysWorld的核心价值,在于开辟了一条"无需真实机器人数据"的学习路径,通过视频生成获取无限的虚拟演示,再用物理建模将其转化为可信的训练信号,最终实现机器人的零样本真实操作。

未来,随着视频生成模型和物理模拟技术的进一步提升,或许我们只需输入文字指令,机器人就能自动生成演示视频、搭建模拟环境、学会操作技能,真正实现"所思即所得"的自主机器人学习。

论文链接:https://arxiv.org/abs/2511.07416

项目地址:https://pointscoder.github.io/PhysWorld_Web/